通⽤⽹络爬⾍是捜索引擎抓取系统(Baidu、Google、Yahoo等)的重要组成部分。主要⽬的是将互联⽹上的⽹⻚下载到本地,形成⼀个互联⽹内容的镜像备份。<br/>

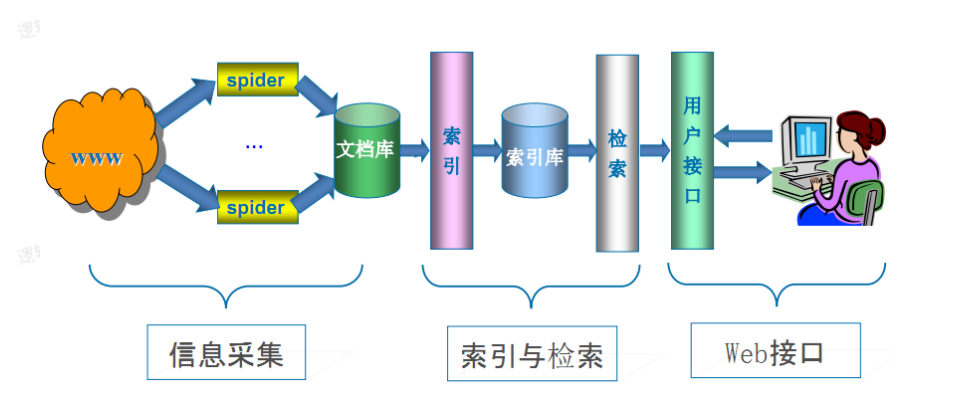

**通⽤搜索引擎(Search Engine)⼯作原理:**

通⽤⽹络爬⾍ 从互联⽹中搜集⽹⻚,采集信息,这些⽹⻚信息⽤于为搜索引擎 建⽴索引从⽽提供⽀持,它决定着整个引擎系统的内容是否丰富,信息是否即 时,因此其性能的优劣直接影响着搜索引擎的效果。<br/>

**第⼀步:抓取网页**

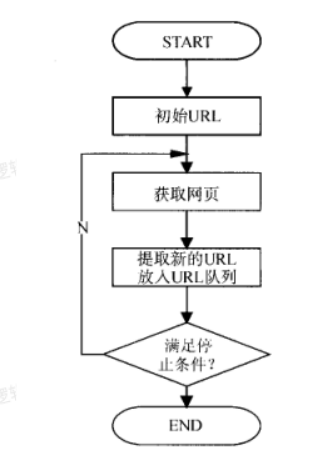

搜索引擎⽹络爬⾍的基本⼯作流程如下:

1. ⾸先选取⼀部分的种⼦URL,将这些URL放⼊待抓取URL队列;

2. 取出待抓取URL,解析DNS得到主机的IP,并将URL对应的⽹⻚下载下来, 存储进已下载⽹⻚库中,并且将这些URL放进已抓取URL队列。

3. 分析已抓取URL队列中的URL,分析其中的其他URL,并且将URL放⼊待抓 取URL队列,从⽽进⼊下⼀个循环....

:-:

通用网络爬虫工作流程图

搜索引擎如何获取⼀个新⽹站的URL:

(1)新⽹站向搜索引擎主动提交⽹址:(如百度 http://zhanzhang.baidu.com/linksubmit/url)。

(2)在其他⽹站上设置新⽹站外链(尽可能处于搜索引擎爬⾍爬取范围)。

(3)搜索引擎和DNS解析服务商(如DNSPod等)合作,新⽹站域名将被迅速抓取。<br/>

<mark>Robots协议:</mark>

Robots协议(也叫爬⾍协议、机器⼈协议等),全称是⽹络爬⾍排除标准(Robots Exclusion Protocol),⽹站通过Robots协议告诉搜索引擎哪些 ⻚⾯可以抓取,哪些⻚⾯不能抓取。

例如: 淘宝⽹:https://www.taobao.com/robots.txt

腾讯⽹: http://www.qq.com/robots.txt

Robots协议只是一种君子约定,从技术层面来讲它不具备反爬虫功能。<br/>

**第⼆步:数据存储**

搜索引擎通过爬⾍爬取到的⽹⻚,将数据存⼊原始⻚⾯数据库。其中的⻚⾯数 据与⽤户浏览器得到的HTML是完全⼀样的。 <br/>

搜索引擎蜘蛛在抓取⻚⾯时,也做⼀定的重复内容检测,⼀旦遇到访问权重很 低的⽹站上有⼤量抄袭、采集或者复制的内容,很可能就不再爬⾏。<br/>

**第三步:预处理**

搜索引擎将爬⾍抓取回来的⻚⾯,进⾏各种步骤的预处理。

* 提取⽂字

* 中⽂分词

* 消除噪⾳(⽐如版权声明⽂字、导航条、⼴告等……)

* 索引处理

* 链接关系计算

* 特殊⽂件处理

**第四步:提供检索服务,⽹站排名**

搜索引擎在对信息进⾏组织和处理后,为⽤户提供关键字检索服务,将⽤户检 索相关的信息展示给⽤户。 <br/>

同时会根据⻚⾯的PageRank值(链接的访问量排名)来进⾏⽹站排名,这样 Rank值⾼的⽹站在搜索结果中会排名较前,当然也可以直接使⽤ Money 购买 搜索引擎⽹站排名,简单粗暴。

<br/>

- 爬虫基本概念

- 爬虫介绍

- 通用爬虫与聚焦爬虫

- 通用爬虫

- 聚焦爬虫

- HTTP与HTTPS协议

- HTTP协议简介

- HTTP的请求与响应

- 客户端HTTP请求

- 服务端HTTP响应

- requests库

- requests库简介

- requests简单使用

- 发送带header的请求

- 发送带参数的请求

- 案例:下载百度贴吧页面

- 发送POST请求

- 使用代理

- 为什么要使用代理?

- 正反向代理

- 代理服务器分类

- 使用代理

- cookie和session

- cookie和session的区别

- 爬虫处理cookie和session

- 使用session登录网站

- 使用cookie登录网站

- cookiejar

- 超时和重试

- verify参数忽略CA证书

- URL地址的解码和编码

- 数据处理

- json数据处理

- json数据处理方案

- json模块处理json数据

- jsonpath处理json数据

- 正则表达式

- lxml

- xpath与lxml介绍

- xpathhelper插件

- 案例

- Beautiful Soup

- Beautiful Soup介绍

- 解析器

- CSS选择器

- 案例

- 四大对象

- 爬虫与反爬虫

- 爬虫与反爬虫的斗争

- 服务器反爬的原因

- 什么样的爬虫会被反爬

- 反爬领域常见概念

- 反爬的三个方向

- 基于身份识别进行反爬

- 基于爬虫行为进行反爬

- 基于数据加密进行反爬

- js解析

- chrome浏览器使用

- 定位js

- 设置断点

- js2py

- hashlib

- 有道翻译案例

- 动态爬取HTML

- 动态HTML

- 获取Ajax数据的方式

- selenium+driver

- driver定位

- 表单元素操作

- 行为链

- cookie操作

- 页面等待

- 多窗口与页面切换

- 配置对象

- 拉勾网案例

- 图片验证码识别

- 图形验证码识别技术简介

- Tesseract

- pytesseract处理图形验证码

- 打码平台

- 登录打码平台

- 验证码种类

- 多任务-线程

- 继承Thread创建线程

- 查看线程数量

- 资源共享

- 互斥锁

- 死锁

- 避免死锁

- Queue线程

- 多线程爬虫

- 多任务-进程

- 创建进程

- 进程池

- 进程间的通信

- Python GIL

- scrapy框架

- scrapy是什么?

- scrapy爬虫流程

- 创建scrapy项目

- Selector选择器

- logging

- scrapy shell

- 保存数据

- Item数据建模

- 翻页请求

- Request

- CrawlSpider

- settings

- 模拟登录

- 保存文件

- 内置Pipeline

- 自定义Pipeline

- 中间件

- selenium动态加载

- 防止反爬

- 随机User-Agent

- 随机IP代理

- settings中的参数

- 随机延迟

- request.meta常用参数

- 分布式爬虫

- 分布式原理

- scrapy_redis

- 去重问题

- 分布式爬虫编写流程

- CrawSpider改写成分布式

- scrapy_splash

- scrapy_splash是什么?

- scrapy_splash环境搭建

- APP抓取

- Android模拟器

- appium

- appium是什么?

- appium环境搭建

- appium环境联调测试

- appium的使用

- 演示项目-抓取抖音app

- 抖音app与appium的联调测试

- 元素定位

- 抖音appium代码

- 抓包软件

- url去重处理