[TOC]

# scheduler调度步骤

kube-scheduler 给一个 Pod 做调度选择时包含两个步骤:

1. 过滤

2. 打分

过滤阶段会将所有满足 Pod 调度需求的节点选出来。 例如,PodFitsResources 过滤函数会检查候选节点的可用资源能否满足 Pod 的资源请求。 在过滤之后,得出一个节点列表,里面包含了所有可调度节点;通常情况下, 这个节点列表包含不止一个节点。如果这个列表是空的,代表这个 Pod 不可调度。

在打分阶段,调度器会为 Pod 从所有可调度节点中选取一个最合适的节点。 根据当前启用的打分规则,调度器会给每一个可调度节点进行打分。

最后,kube-scheduler 会将 Pod 调度到得分最高的节点上。 如果存在多个得分最高的节点,kube-scheduler 会从中随机选取一个。

# 常见问题

## 调度不均衡

通常反馈都是内存不均衡。比如集群有三个节点,一台是128G内存,两台是64G内存。预想的是三台使用内存百分比差不多。实际上两台64G内存差不多跑满了,另一台128G内存才跑了50%左右。

为什么会出现这种问题呢?

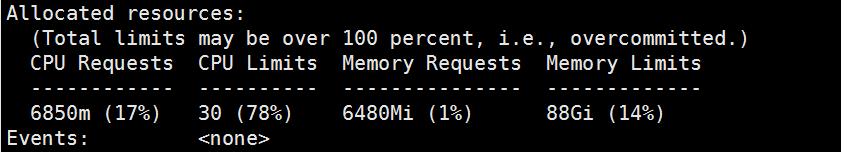

> 我们先了解下调度的其中一个打分。k8s调度认为内存使用情况是 `节点总共调度的request值(kubectl describe node k8s-node01)` 最下面有打印(示例如下)

>

**由此可见**:调度的时候不是按照主机实际使用内存情况,而是根据 该节点request总值来评估使用率。

**总结和建议**:pod设置一定要设置 request 值,且设置的时候与实际跑的内存相符。设置request值与实际跑的内存差距太大会出现如上情况。

## 监控主机内存接近满载不驱逐

k8s是有自己一套主机内存判断机制是否到达驱逐临界定。[官网提供k8s检测脚本](https://kubernetes.io/zh-cn/examples/admin/resource/memory-available.sh) / [【备份】本地下载官方k8s检测脚本](./memory-available.sh) 判断是否超过驱逐临界点。超过该临界点则开始驱逐pod。临界点是 `--eviction-hard` 参数配置。查看配置的情况 `ps -ef | grep [k]ubelet | grep 'eviction-hard=memory.available'`

**由此可见**:可能与监控主机内存有出入,需参考上面提供脚本测试是否到达驱逐标准。

>[info] **总结**:通过 `free -h` 不是判断驱逐条件,所有还是使用上面脚本为准哈。

# 参考文章

节点压力驱逐:https://kubernetes.io/zh-cn/docs/concepts/scheduling-eviction/node-pressure-eviction/

- 前言

- 架构

- 部署

- kubeadm部署

- kubeadm扩容节点

- 二进制安装基础组件

- 添加master节点

- 添加工作节点

- 选装插件安装

- Kubernetes使用

- k8s与dockerfile启动参数

- hostPort与hostNetwork异同

- 应用上下线最佳实践

- 进入容器命名空间

- 主机与pod之间拷贝

- events排序问题

- k8s会话保持

- 容器root特权

- CNI插件

- calico

- calicoctl安装

- calico网络通信

- calico更改pod地址范围

- 新增节点网卡名不一致

- 修改calico模式

- calico数据存储迁移

- 启用 kubectl 来管理 Calico

- calico卸载

- cilium

- cilium架构

- cilium/hubble安装

- cilium网络路由

- IP地址管理(IPAM)

- Cilium替换KubeProxy

- NodePort运行DSR模式

- IP地址伪装

- ingress使用

- nginx-ingress

- ingress安装

- ingress高可用

- helm方式安装

- 基本使用

- Rewrite配置

- tls安全路由

- ingress发布管理

- 代理k8s集群外的web应用

- ingress自定义日志

- ingress记录真实IP地址

- 自定义参数

- traefik-ingress

- traefik名词概念

- traefik安装

- traefik初次使用

- traefik路由(IngressRoute)

- traefik中间件(middlewares)

- traefik记录真实IP地址

- cert-manager

- 安装教程

- 颁布者CA

- 创建证书

- 外部存储

- 对接NFS

- 对接ceph-rbd

- 对接cephfs

- 监控平台

- Prometheus

- Prometheus安装

- grafana安装

- Prometheus配置文件

- node_exporter安装

- kube-state-metrics安装

- Prometheus黑盒监控

- Prometheus告警

- grafana仪表盘设置

- 常用监控配置文件

- thanos

- Prometheus

- Sidecar组件

- Store Gateway组件

- Querier组件

- Compactor组件

- Prometheus监控项

- grafana

- Querier对接grafana

- alertmanager

- Prometheus对接alertmanager

- 日志中心

- filebeat安装

- kafka安装

- logstash安装

- elasticsearch安装

- elasticsearch索引生命周期管理

- kibana安装

- event事件收集

- 资源预留

- 节点资源预留

- imagefs与nodefs验证

- 资源预留 vs 驱逐 vs OOM

- scheduler调度原理

- Helm

- Helm安装

- Helm基本使用

- 安全

- apiserver审计日志

- RBAC鉴权

- namespace资源限制

- 加密Secret数据

- 服务网格

- 备份恢复

- Velero安装

- 备份与恢复

- 常用维护操作

- container runtime

- 拉取私有仓库镜像配置

- 拉取公网镜像加速配置

- runtime网络代理

- overlay2目录占用过大

- 更改Docker的数据目录

- Harbor

- 重置Harbor密码

- 问题处理

- 关闭或开启Harbor的认证

- 固定harbor的IP地址范围

- ETCD

- ETCD扩缩容

- ETCD常用命令

- ETCD数据空间压缩清理

- ingress

- ingress-nginx header配置

- kubernetes

- 验证yaml合法性

- 切换KubeProxy模式

- 容器解析域名

- 删除节点

- 修改镜像仓库

- 修改node名称

- 升级k8s集群

- 切换容器运行时

- apiserver接口

- 其他

- 升级内核

- k8s组件性能分析

- ETCD

- calico

- calico健康检查失败

- Harbor

- harbor同步失败

- Kubernetes

- 资源Terminating状态

- 启动容器报错