[TOC]

Kubernetes 集群中, 在 Kube Proxy 里大量用到了 iptables, 在 Kubernetes 集群规模较大的情况下, 数以千/万计的 iptables 规则会极大地拖慢 Kubernetes 网络性能, 导致网络请求响应缓慢.

# Kube Proxy 的用途

Kube Proxy 的负责以下几个方面的流量路由:

1. ClusterIP: 集群内通过 ClusterIP 的访问

2. NodePort: 集群内外通过 NodePort 的访问

3. ExternalIP: 集群外通过 external IP 的访问

4. LoadBalancer: 集群外通过 LoadBalancer 的访问.

以上功能 cilium 均已实现,并且性能更加强悍。

# cilium与kubeProxy性能对比

Cilium 完全实现了 kube-proxy 功能, 并做到了性能上有所提升, 具体 [Cilium 官方测试结果](https://cilium.io/blog/2019/08/20/cilium-16/)

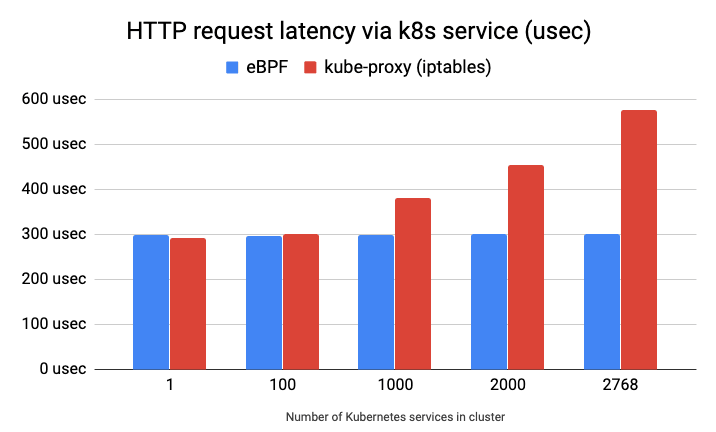

>[info] 下图显示了通过 Kubernetes 服务发送到远程主机上运行的 nginx Pod 的每个 HTTP GET 请求的延迟(越低越好),使用 `ab` 发送 100,000 个连续请求来测量。 正如我们所看到的,eBPF 服务实现不依赖于集群中部署的服务数量,而使用 iptables 的 kube-proxy 实现却依赖于集群中部署的服务数量。

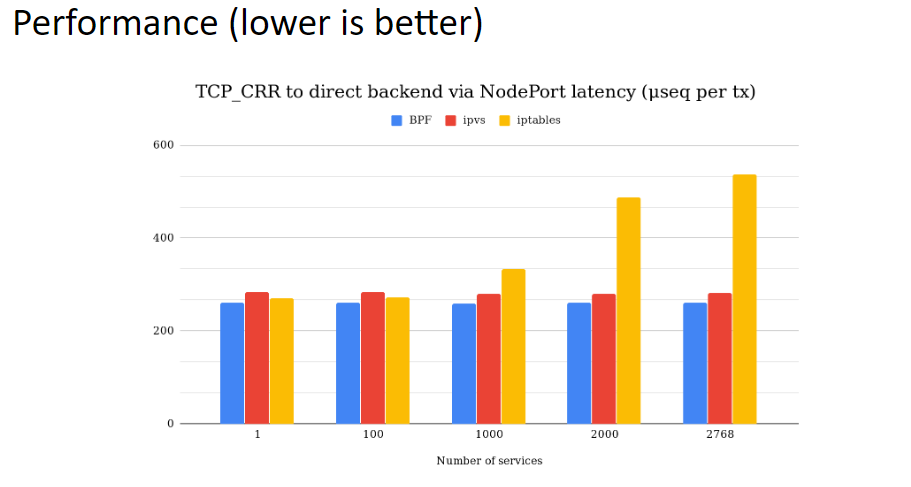

在 [Google文档](https://docs.google.com/presentation/d/1cZJ-pcwB9WG88wzhDm2jxQY4Sh8adYg0-N3qWQ8593I/edit?pli=1#slide=id.g708c5740c0_0_216) 找到提及多个转发(iptables, ipvs, eBPF)方式对比结果。该文档创建者也是撰写 [cilium官网替换kube-proxy性能提升](https://cilium.io/blog/2019/08/20/cilium-16/) 的两位测试之中的一员。数据估计是可靠的

>[info] 从这个结果来看,kubeProxy中 ipvs 模式与 eBPF 相差不远。两者都不会跟随 Service 增加而降低性能

# 实施 cilium 替换 kube-proxy

## 前提条件

- Cilium 的 kube-proxy 替换依赖于 socket-LB 功能,这需要 v4.19.57、v5.1.16、v5.2.0 或更高版本的 Linux 内核

## 逐步替换节点

1. kube-proxy 设置节点反亲和性

```shell

$ kubectl -n kube-system patch daemonset kube-proxy --patch '{"spec": {"template": {"spec": {"affinity": {"nodeAffinity": {"requiredDuringSchedulingIgnoredDuringExecution": {"nodeSelectorTerms": [{"matchExpressions": [{"key": "io.cilium.migration/kube-proxy-replacement", "operator": "NotIn", "values": ["strict"]}]}]}}}}}}}'

```

2. 设置cilium节点配置

```shell

$ cat <<EOF | kubectl apply --server-side -f -

apiVersion: cilium.io/v2alpha1

kind: CiliumNodeConfig

metadata:

namespace: kube-system

name: kube-proxy-replacement-strict

spec:

nodeSelector:

matchLabels:

io.cilium.migration/kube-proxy-replacement: strict

defaults:

kube-proxy-replacement: strict

kube-proxy-replacement-healthz-bind-address: "0.0.0.0:10256"

EOF

ciliumnodeconfig.cilium.io/kube-proxy-replacement-strict serverside-applied

```

3. 节点禁止调度

```shell

$ export NODE=192.168.32.127

$ kubectl cordon $NODE

```

4. 节点设置label

```shell

$ export NODE=192.168.32.127

$ kubectl label node $NODE --overwrite 'io.cilium.migration/kube-proxy-replacement=strict'

```

5. 重启cilium

```shell

$ export NODE=192.168.32.127

$ kubectl -n kube-system delete pod -l k8s-app=cilium --field-selector spec.nodeName=$NODE

```

6. 确认cilium启动参数

```shell

$ export NODE=192.168.32.127

$ kubectl -n kube-system exec $(kubectl -n kube-system get pod -l k8s-app=cilium --field-selector spec.nodeName=$NODE -o name) -c cilium-agent -- cilium config get kube-proxy-replacement

$ kubectl -n kube-system exec $(kubectl -n kube-system get pod -l k8s-app=cilium --field-selector spec.nodeName=$NODE -o name) -c cilium-agent -- cilium status --verbose

...

KubeProxyReplacement Details:

Status: Strict

Socket LB: Enabled

Socket LB Tracing: Enabled

Socket LB Coverage: Full

Devices: ens33 192.168.32.127

Mode: SNAT

Backend Selection: Random

Session Affinity: Enabled

Graceful Termination: Enabled

NAT46/64 Support: Disabled

XDP Acceleration: Disabled

Services:

- ClusterIP: Enabled

- NodePort: Enabled (Range: 30000-32767)

- LoadBalancer: Enabled

- externalIPs: Enabled

- HostPort: Enabled

...

```

7. 节点运行调度

```shell

$ export NODE=192.168.32.127

$ kubectl uncordon $NODE

```

8. 逐步替换其他节点

替换其他节点,只需从第 `3-7` 步执行。将 NODE 变量改成需要替换的k8s节点名称

9. 修改cilium配置文件

>[info] 集群中所有节点都替换完成后才执行此步骤

```shell

# 获取当前版本号

cilium_version=$(helm -n kube-system ls | awk '/cilium/ {print $NF}')

echo $cilium_version

# 备份上一次安装的参数

helm -n kube-system get values cilium > cilium_custom.yaml

sed -i '1d' cilium_custom.yaml

# 添加参数

cat <<EOF | tee -a cilium_custom.yaml >> /dev/null

# 在 Cilium BPF 数据路径中配置 kube-proxy 替换

kubeProxyReplacement: "strict"

# 用于 kube-proxy 替换的 healthz 服务器绑定地址

kubeProxyReplacementHealthzBindAddr: "0.0.0.0:10256"

EOF

# 修改参数

helm -n kube-system upgrade cilium cilium/cilium --version $cilium_version -f cilium_custom.yaml

```

10. 删除cilium节点配置

```shell

$ kubectl -n kube-system delete ciliumnodeconfig kube-proxy-replacement-strict

```

11. 卸载kube-proxy服务

```shell

$ kubectl -n kube-system delete ds kube-proxy

$ kubectl -n kube-system delete cm kube-proxy

$ iptables-save | grep -v KUBE | iptables-restore

```

12. 取消节点 label 标签

```shell

$ kubectl label node --all --overwrite 'io.cilium.migration/kube-proxy-replacement-'

```

- 前言

- 架构

- 部署

- kubeadm部署

- kubeadm扩容节点

- 二进制安装基础组件

- 添加master节点

- 添加工作节点

- 选装插件安装

- Kubernetes使用

- k8s与dockerfile启动参数

- hostPort与hostNetwork异同

- 应用上下线最佳实践

- 进入容器命名空间

- 主机与pod之间拷贝

- events排序问题

- k8s会话保持

- 容器root特权

- CNI插件

- calico

- calicoctl安装

- calico网络通信

- calico更改pod地址范围

- 新增节点网卡名不一致

- 修改calico模式

- calico数据存储迁移

- 启用 kubectl 来管理 Calico

- calico卸载

- cilium

- cilium架构

- cilium/hubble安装

- cilium网络路由

- IP地址管理(IPAM)

- Cilium替换KubeProxy

- NodePort运行DSR模式

- IP地址伪装

- ingress使用

- nginx-ingress

- ingress安装

- ingress高可用

- helm方式安装

- 基本使用

- Rewrite配置

- tls安全路由

- ingress发布管理

- 代理k8s集群外的web应用

- ingress自定义日志

- ingress记录真实IP地址

- 自定义参数

- traefik-ingress

- traefik名词概念

- traefik安装

- traefik初次使用

- traefik路由(IngressRoute)

- traefik中间件(middlewares)

- traefik记录真实IP地址

- cert-manager

- 安装教程

- 颁布者CA

- 创建证书

- 外部存储

- 对接NFS

- 对接ceph-rbd

- 对接cephfs

- 监控平台

- Prometheus

- Prometheus安装

- grafana安装

- Prometheus配置文件

- node_exporter安装

- kube-state-metrics安装

- Prometheus黑盒监控

- Prometheus告警

- grafana仪表盘设置

- 常用监控配置文件

- thanos

- Prometheus

- Sidecar组件

- Store Gateway组件

- Querier组件

- Compactor组件

- Prometheus监控项

- grafana

- Querier对接grafana

- alertmanager

- Prometheus对接alertmanager

- 日志中心

- filebeat安装

- kafka安装

- logstash安装

- elasticsearch安装

- elasticsearch索引生命周期管理

- kibana安装

- event事件收集

- 资源预留

- 节点资源预留

- imagefs与nodefs验证

- 资源预留 vs 驱逐 vs OOM

- scheduler调度原理

- Helm

- Helm安装

- Helm基本使用

- 安全

- apiserver审计日志

- RBAC鉴权

- namespace资源限制

- 加密Secret数据

- 服务网格

- 备份恢复

- Velero安装

- 备份与恢复

- 常用维护操作

- container runtime

- 拉取私有仓库镜像配置

- 拉取公网镜像加速配置

- runtime网络代理

- overlay2目录占用过大

- 更改Docker的数据目录

- Harbor

- 重置Harbor密码

- 问题处理

- 关闭或开启Harbor的认证

- 固定harbor的IP地址范围

- ETCD

- ETCD扩缩容

- ETCD常用命令

- ETCD数据空间压缩清理

- ingress

- ingress-nginx header配置

- kubernetes

- 验证yaml合法性

- 切换KubeProxy模式

- 容器解析域名

- 删除节点

- 修改镜像仓库

- 修改node名称

- 升级k8s集群

- 切换容器运行时

- apiserver接口

- 其他

- 升级内核

- k8s组件性能分析

- ETCD

- calico

- calico健康检查失败

- Harbor

- harbor同步失败

- Kubernetes

- 资源Terminating状态

- 启动容器报错