[TOC]

# 垃圾回收

* 如何判定对象为垃圾对象

- 引用计数法

- 可达性分析法

* 回收策略

- 标记-清除算法

- 复制算法

- 标记-整理算法

- 分代回收算法

* 垃圾回收器

- Serial

- Parnew

- Cms

- G1

# 算法

## 引用计数算法

在对象中添加一个引用计数器,当有地方引用这个对象的时候,引用计数器的值就+1,当引用失效的时候,计数器的值就-1.

打印gc信息

* -verbose:gc

* -xx:+PrintGCDetails

## 可达性分析算法

作为GCRoots的对象

* 虚拟机栈

* 方法区的类属性所引用的对象

* 方法区中常量所引用的对象

* 本地方法栈中引用的对象

## 标记-清除算法

* 效率问题

* 空间问题,空间碎片

## 复制算法

* 堆

- 新生代

- Eden伊甸园

- Survivor 存活区

- Tenured Gen

- 老年代

将内存分为一大块Eden和其中一块Survivor.

当Eden和Survivor中还存活着的对象一次性复制到另一块Survivor空间上.

最后清理到刚才的Eden和Survivor.

默认Eden和Survivior比例是8:1.

当Survivor空间不够用的时候需要依赖其他内存(老年代),进行分配担保

## 标记-整理算法

标记过程和标记-清除算法一样.

后续不是直接对可回收对象进行整理,而是让所有存活的对象都向一端移动,然后直接清理掉端边界以外的内存

## 分代收集算法

根据对象的存活周期,把堆分为新生代和老年代.

根据不同区域选择最适当的算法.

在新生代中,每次垃圾收集时都发现有大批对象死去,只有少量的存活,那就用复制算法,只要付出少量存活对象的复制成本就可以完成收集.

老年代中因为对象存活率高,没有额外空间对他进行分配担保,那就用标记-清理,标记-整理算法

# HotSpot算法实现

# 相关概念

## 并行和并发

* **并行(Parallel)**:指多条垃圾收集线程并行工作,但此时用户线程仍然处于等待状态。

* **并发(Concurrent)**:指用户线程与垃圾收集线程同时执行(但不一定是并行的,可能会交替执行),用户程序在继续运行。而垃圾收集程序运行在另一个CPU上。

## 吞吐量(Throughput)

吞吐量就是**CPU用于运行用户代码的时间**与**CPU总消耗时间**的比值,即

**吞吐量 = 运行用户代码时间 /(运行用户代码时间 + 垃圾收集时间)。**

假设虚拟机总共运行了100分钟,其中垃圾收集花掉1分钟,那吞吐量就是99%。

## Minor GC 和 Full GC

* **新生代GC(Minor GC)**:指发生在新生代的垃圾收集动作,因为Java对象大多都具备朝生夕灭的特性,所以Minor GC非常频繁,一般回收速度也比较快。具体原理见上一篇文章。

* **老年代GC(Major GC / Full GC)**:指发生在老年代的GC,出现了Major GC,经常会伴随至少一次的Minor GC(但非绝对的,在Parallel Scavenge收集器的收集策略里就有直接进行Major GC的策略选择过程)。Major GC的速度一般会比Minor GC慢10倍以上。

## 收集器配合

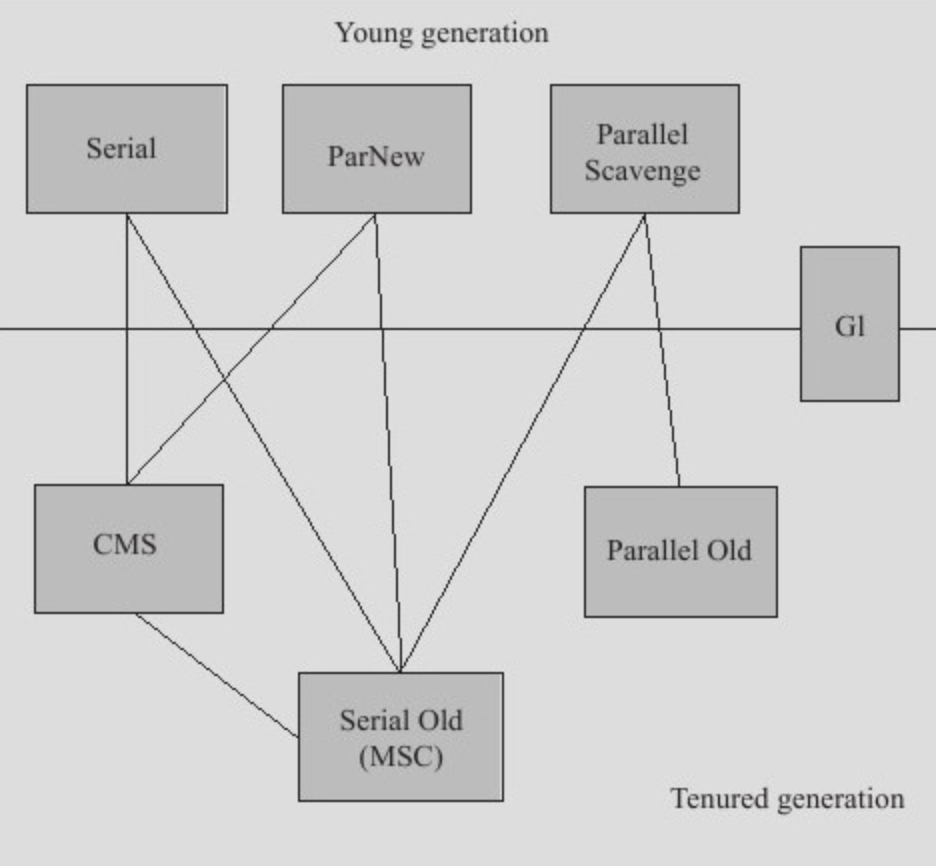

展示了7种作用于不同分代的收集器,如果两个收集器之间存在连线,就说明它们可以搭配使用。虚拟机所处的区域,则表示它是属于新生代收集器还是老年代收集器。

Hotspot实现了如此多的收集器,正是因为目前并无完美的收集器出现,只是选择对具体应用最适合的收集器。

## YGC和FGC是什么

YGC :对新生代堆进行gc。频率比较高,因为大部分对象的存活寿命较短,在新生代里被回收。性能耗费较小。

FGC :全堆范围的gc。默认堆空间使用到达80%(可调整)的时候会触发fgc。以我们生产环境为例,一般比较少会触发fgc,有时10天或一周左右会有一次。

## 什么时候执行YGC和FGC

**YGC的时机:**

* edn空间不足

**FGC的时机:**

* old空间不足;

* perm空间不足;

* 显示调用System.gc() ,包括RMI等的定时触发;

* YGC时的悲观策略;

* dump live的内存信息时(jmap –dump:live)。

对YGC的 触发时机,相当的显而易见,就是eden空间不足, 这时候就肯定会触发ygc

对于FGC的触发时机, old空间不足, 和perm的空间不足, 调用system.gc()这几个都比较显而易见,就是在这种情况下, 一般都会触发GC。

最复杂的是所谓的悲观策略,它触发的机制是在首先会计算之前晋升的平均大小,也就是从新生代,通过ygc变成新生代的平均大小,然后如果旧生代剩余的空间小于晋升大小,那么就会触发一次FullGC。sdk考虑的策略是, 从平均和长远的情况来看,下次晋升空间不够的可能性非常大, 与其等到那时候在fullGC 不如悲观的认为下次肯定会触发FullGC, 直接先执行一次FullGC。而且从实际使用过程中来看, 也达到了比较稳定的效果。

# 新生代收集器

## Serial收集器

**Stop The World**

* 单线程垃圾收集器

* 桌面应用

只会使用一个cpu或者一条收集器会完成,中间这段时间会停止其他线程,等待GC完成.

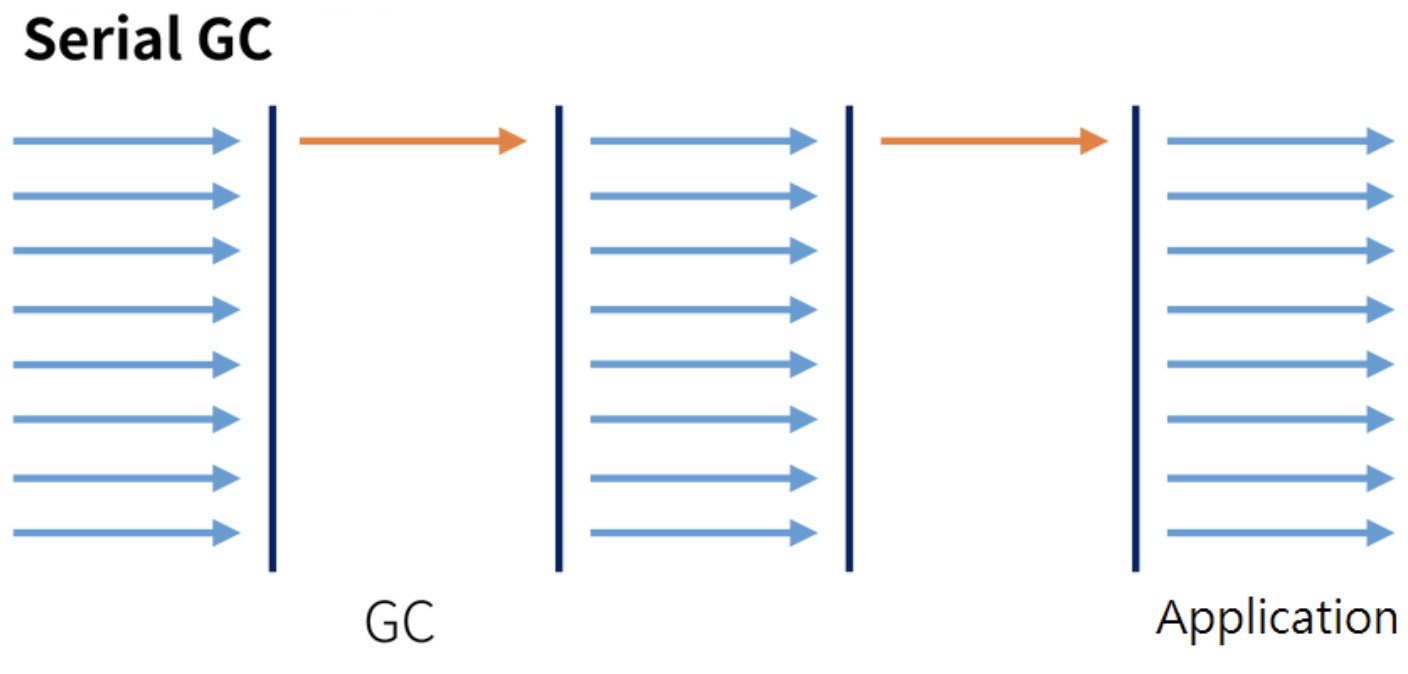

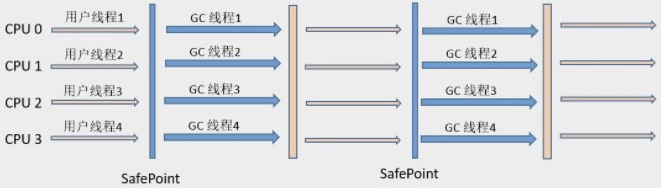

下图展示了Serial 收集器(老年代采用Serial Old收集器)的运行过程:

## ParNew收集器

Serial收集器多线程版本,使用多线程进行GC

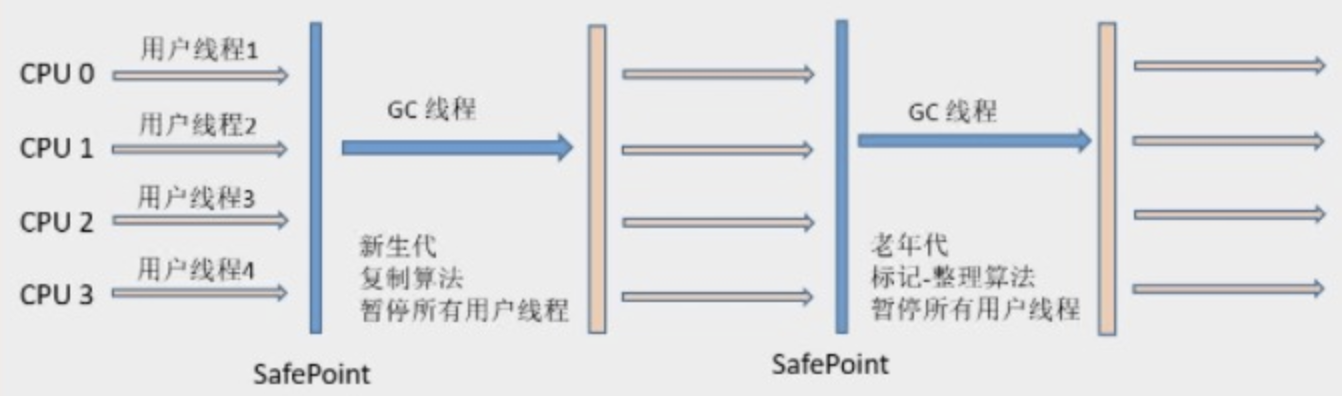

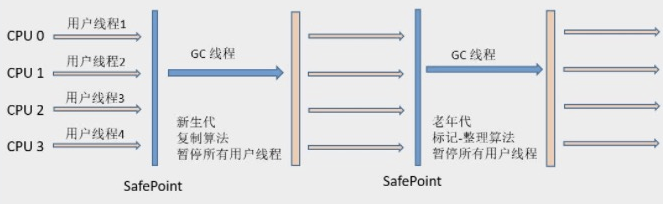

ParNew收集器的工作过程如下图(老年代采用Serial Old收集器):

**除了Serial收集器外,目前只有它能和CMS收集器(Concurrent Mark Sweep)配合工作**

默认开启的收集线程数与CPU的数量相同,在CPU非常多的情况下可使用**\-XX:ParallerGCThreads**参数设置

## Parallel Scavenge收集器

是一个**并行**的**多线程新生代**收集器,它也使用**复制算法**

CMS等收集器的关注点是尽可能缩短垃圾收集时用户线程的停顿时间,而Parallel Scavenge收集器的目标是**达到一个可控制的吞吐量(Throughput)**

**停顿时间越短就越适合需要与用户交互的程序**,良好的响应速度能提升用户体验。而**高吞吐量**则可以高效率地利用CPU时间,尽快完成程序的运算任务,主要适合**在后台运算而不需要太多交互的任务**。

除了会显而易见地提供可以精确控制吞吐量的参数,还提供了一个参数**\-XX:+UseAdaptiveSizePolicy**,这是一个开关参数,打开参数后,就不需要手工指定新生代的大小(-Xmn)、Eden和Survivor区的比例(-XX:SurvivorRatio)、晋升老年代对象年龄(-XX:PretenureSizeThreshold)等细节参数了,虚拟机会根据当前系统的运行情况收集性能监控信息,动态调整这些参数以提供最合适的停顿时间或者最大的吞吐量,这种方式称为**GC自适应的调节策略(GC Ergonomics)**。自适应调节策略也是Parallel Scavenge收集器与ParNew收集器的一个重要区别。

控制吞吐量(执行用户代码时间 / (执行用户代码的时间 + 垃圾回收所占用的时间))

* -XX:MaxGFPauseMillis垃圾收集器停顿时间

* -XX:CGTimeRatio吞吐量大小

- (0, 100)吞吐量大小

- 99默认

# 老年代收集器

## Serial Old收集器

Serial Old 是 Serial收集器的老年代版本,它同样是一个**单线程收集器**,使用**“标记-整理”(Mark-Compact)**算法。

此收集器的主要意义也是在于给Client模式下的虚拟机使用。如果在Server模式下,它还有两大用途:

* 在JDK1.5 以及之前版本(Parallel Old诞生以前)中与Parallel Scavenge收集器搭配使用。

* 作为CMS收集器的后备预案,在并发收集发生**Concurrent Mode Failure**时使用

它的工作流程与Serial收集器相同,这里再次给出Serial/Serial Old配合使用的工作流程图:

## Parallel Old收集器

Parallel Old收集器是Parallel Scavenge收集器的老年代版本,使用**多线程**和**“标记-整理”**算法.

**吞吐量优先”收集器**终于有了比较名副其实的应用组合,在**注重吞吐量**以及**CPU资源敏感**的场合,都可以优先考虑Parallel Scavenge加Parallel Old收集器。Parallel Old收集器的工作流程与Parallel Scavenge相同,这里给出Parallel Scavenge/Parallel Old收集器配合使用的流程图:

## CMS收集器

是一种以**获取最短回收停顿时间**为目标的收集器,它非常符合那些集中在互联网站或者B/S系统的服务端上的Java应用,这些应用都非常重视服务的响应速度

**并发的标记-清除收集器**

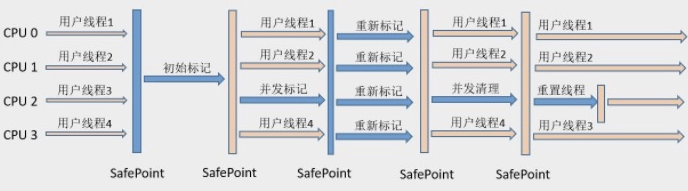

* 工作过程

- 初始标记:仅仅只是标记一下GC Roots能直接关联到的对象,速度很快,需要“Stop The World”.

- 并发标记:进行**GC Roots Tracing**的过程,在整个过程中耗时最长.

- 重新标记:为了修正并发标记期间因用户程序继续运作而导致标记产生变动的那一部分对象的标记记录,这个阶段的停顿时间一般会比初始标记阶段稍长一些,但远比并发标记的时间短。此阶段也需要“Stop The World”.

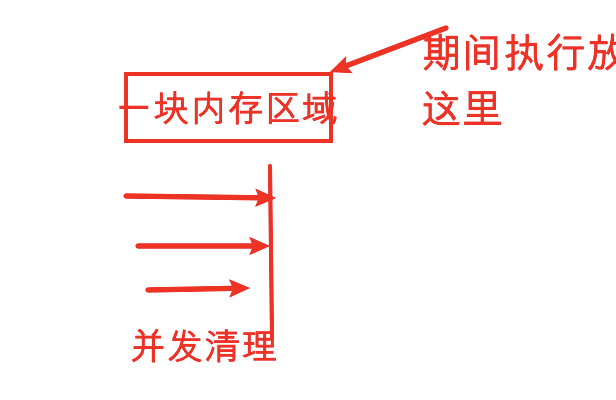

- 并发清理

如果那块内存区域给的不够会出现Concurrent Mode Failure

* 优点

- 并发收集

- 低停顿

* 缺点

- 占用大量的cpu资源

- 无法处理浮动垃圾

- 出现Concurrent Mode Failure

- 空间碎片: 标记-清除算法

可能出现“Concurrent Mode Failure”失败而导致另一次Full GC的产生。**由于CMS并发清理阶段用户线程还在运行着,伴随程序运行自然就还会有新的垃圾不断产生。**这一部分垃圾出现在标记过程之后,CMS无法再当次收集中处理掉它们,只好留待下一次GC时再清理掉。这一部分垃圾就被称为**“浮动垃圾”**。也是由于在垃圾收集阶段用户线程还需要运行,那也就还需要预留有足够的内存空间给用户线程使用,因此CMS收集器不能像其他收集器那样等到老年代几乎完全被填满了再进行收集,需要预留一部分空间提供并发收集时的程序运作使用。

# G1收集器

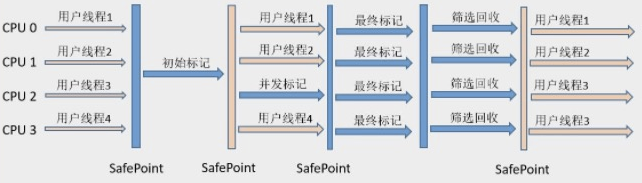

步骤

* **初始标记(Initial Marking)**仅仅只是标记一下GC Roots 能直接关联到的对象,并且修改**TAMS(Nest Top Mark Start)**的值,让下一阶段用户程序并发运行时,能在正确可以的Region中创建对象,此阶段需要**停顿线程**,但耗时很短。

* **并发标记(Concurrent Marking)**从GC Root 开始对堆中对象进行**可达性分析**,找到存活对象,此阶段耗时较长,但**可与用户程序并发执行**。

* **最终标记(Final Marking)**为了修正在并发标记期间因用户程序继续运作而导致标记产生变动的那一部分标记记录,虚拟机将这段时间对象变化记录在**线程的Remembered Set Logs**里面,最终标记阶段需要**把Remembered Set Logs的数据合并到Remembered Set中**,这阶段需要**停顿线程**,但是**可并行执行**。

* **筛选回收(Live Data Counting and Evacuation)** 首先对各个Region中的回收价值和成本进行排序,根据用户所期望的GC 停顿是时间来制定回收计划。此阶段其实也可以做到与用户程序一起并发执行,但是因为只回收一部分Region,时间是用户可控制的,而且停顿用户线程将大幅度提高收集效率。

通过下图可以比较清楚地看到G1收集器的运作步骤中并发和需要停顿的阶段(Safepoint处):

**横跨整个堆内存**

在G1之前的其他收集器进行收集的范围都是整个新生代或者老生代,而G1不再是这样。G1在使用时,Java堆的内存布局与其他收集器有很大区别,它**将整个Java堆划分为多个大小相等的独立区域(Region)**,虽然还保留新生代和老年代的概念,但**新生代和老年代不再是物理隔离的了,而都是一部分Region(不需要连续)的集合**

**有计划地避免在整个Java堆中进行全区域的垃圾收集**

**在后台维护一个优先列表**

**优先回收价值最大的Region**

**避免全堆扫描——Remembered Set**

为了避免全堆扫描的发生,虚拟机**为G1中每个Region维护了一个与之对应的Remembered Set**。虚拟机发现程序在对Reference类型的数据进行写操作时,会产生一个Write Barrier暂时中断写操作,检查Reference引用的对象是否处于不同的Region之中(在分代的例子中就是检查是否老年代中的对象引用了新生代中的对象),如果是,便通过CardTable**把相关引用信息记录到被引用对象所属的Region的Remembered Set之中**。当进行内存回收时,在GC根节点的枚举范围中加入Remembered Set即可保证不对全堆扫描也不会有遗漏。

* 优势

- 并行与并发

- 分代收集

- 空间整合: 整体来看是基于标记-整理,从局部(两个Region之间)上来看是基于复制算法实现的

- 可预测的停顿

* 步骤

- 初始标记

- 并发标记

- 最终标记

- 筛选回收

- 基础

- 编译和安装

- classpath到底是什么?

- 编译运行

- 安装

- sdkman多版本

- jabba多版本

- java字节码查看

- 数据类型

- 简介

- 整形

- char和int

- 变量和常量

- 大数值运算

- 基本类型包装类

- Math类

- 内存划分

- 位运算符

- 方法相关

- 方法重载

- 可变参数

- 方法引用

- 面向对象

- 定义

- 继承和覆盖

- 接口和抽象类

- 接口定义增强

- 内建函数式接口

- 多态

- 泛型

- final和static

- 内部类

- 包

- 修饰符

- 异常

- 枚举类

- 代码块

- 对象克隆

- BeanUtils

- java基础类

- scanner类

- Random类

- System类

- Runtime类

- Comparable接口

- Comparator接口

- MessageFormat类

- NumberFormat

- 数组相关

- 数组

- Arrays

- string相关

- String

- StringBuffer

- StringBuilder

- 正则

- 日期类

- Locale类

- Date

- DateFormat

- SimpleDateFormat

- Calendar

- 新时间日期API

- 简介

- LocalDate,LocalTime,LocalDateTime

- Instant时间点

- 带时区的日期,时间处理

- 时间间隔

- 日期时间校正器

- TimeUnit

- 用yyyy

- 集合

- 集合和迭代器

- ArrayList集合

- List

- Set

- 判断集合唯一

- Map和Entry

- stack类

- Collections集合工具类

- Stream数据流

- foreach不能修改内部元素

- of方法

- IO

- File类

- 字节流stream

- 字符流Reader

- IO流分类

- 转换流

- 缓冲流

- 流的操作规律

- properties

- 序列化流与反序列化流

- 打印流

- System类对IO支持

- commons-IO

- IO流总结

- NIO

- 异步与非阻塞

- IO通信

- Unix的IO模型

- epoll对于文件描述符操作模式

- 用户空间和内核空间

- NIO与普通IO的主要区别

- Paths,Path,Files

- Buffer

- Channel

- Selector

- Pipe

- Charset

- NIO代码

- 多线程

- 创建线程

- 线程常用方法

- 线程池相关

- 线程池概念

- ThreadPoolExecutor

- Runnable和Callable

- 常用的几种线程池

- 线程安全

- 线程同步的几种方法

- synchronized

- 死锁

- lock接口

- ThreadLoad

- ReentrantLock

- 读写锁

- 锁的相关概念

- volatile

- 释放锁和不释放锁的操作

- 等待唤醒机制

- 线程状态

- 守护线程和普通线程

- Lamda表达式

- 反射相关

- 类加载器

- 反射

- 注解

- junit注解

- 动态代理

- 网络编程相关

- 简介

- UDP

- TCP

- 多线程socket上传图片

- NIO

- JDBC相关

- JDBC

- 预处理

- 批处理

- 事务

- properties配置文件

- DBUtils

- DBCP连接池

- C3P0连接池

- 获得MySQL自动生成的主键

- Optional类

- Jigsaw模块化

- 日志相关

- JDK日志

- log4j

- logback

- xml

- tomcat

- maven

- 简介

- 仓库

- 目录结构

- 常用命令

- 生命周期

- idea配置

- jar包冲突

- 依赖范围

- 私服

- 插件

- git-commit-id-plugin

- maven-assembly-plugin

- maven-resources-plugin

- maven-compiler-plugin

- versions-maven-plugin

- maven-source-plugin

- tomcat-maven-plugin

- 多环境

- 自定义插件

- stream

- swing

- json

- jackson

- optional

- junit

- gradle

- servlet

- 配置

- ServletContext

- 生命周期

- HttpServlet

- request

- response

- 乱码

- session和cookie

- cookie

- session

- jsp

- 简介

- 注释

- 方法,成员变量

- 指令

- 动作标签

- 隐式对象

- EL

- JSTL

- javaBean

- listener监听器

- Filter过滤器

- 图片验证码

- HttpUrlConnection

- 国际化

- 文件上传

- 文件下载

- spring

- 简介

- Bean

- 获取和实例化

- 属性注入

- 自动装配

- 继承和依赖

- 作用域

- 使用外部属性文件

- spel

- 前后置处理器

- 生命周期

- 扫描规则

- 整合多个配置文件

- 注解

- 简介

- 注解分层

- 类注入

- 分层和作用域

- 初始化方法和销毁方法

- 属性

- 泛型注入

- Configuration配置文件

- aop

- aop的实现

- 动态代理实现

- cglib代理实现

- aop名词

- 简介

- aop-xml

- aop-注解

- 代理方式选择

- jdbc

- 简介

- JDBCTemplate

- 事务

- 整合

- junit整合

- hibernate

- 简介

- hibernate.properties

- 实体对象三种状态

- 检索方式

- 简介

- 导航对象图检索

- OID检索

- HQL

- Criteria(QBC)

- Query

- 缓存

- 事务管理

- 关系映射

- 注解

- 优化

- MyBatis

- 简介

- 入门程序

- Mapper动态代理开发

- 原始Dao开发

- Mapper接口开发

- SqlMapConfig.xml

- map映射文件

- 输出返回map

- 输入参数

- pojo包装类

- 多个输入参数

- resultMap

- 动态sql

- 关联

- 一对一

- 一对多

- 多对多

- 整合spring

- CURD

- 占位符和sql拼接以及参数处理

- 缓存

- 延迟加载

- 注解开发

- springMVC

- 简介

- RequestMapping

- 参数绑定

- 常用注解

- 响应

- 文件上传

- 异常处理

- 拦截器

- springBoot

- 配置

- 热更新

- java配置

- springboot配置

- yaml语法

- 运行

- Actuator 监控

- 多环境配置切换

- 日志

- 日志简介

- logback和access

- 日志文件配置属性

- 开机自启

- aop

- 整合

- 整合Redis

- 整合Spring Data JPA

- 基本查询

- 复杂查询

- 多数据源的支持

- Repository分析

- JpaSpecificationExecutor

- 整合Junit

- 整合mybatis

- 常用注解

- 基本操作

- 通用mapper

- 动态sql

- 关联映射

- 使用xml

- spring容器

- 整合druid

- 整合邮件

- 整合fastjson

- 整合swagger

- 整合JDBC

- 整合spingboot-cache

- 请求

- restful

- 拦截器

- 常用注解

- 参数校验

- 自定义filter

- websocket

- 响应

- 异常错误处理

- 文件下载

- 常用注解

- 页面

- Thymeleaf组件

- 基本对象

- 内嵌对象

- 上传文件

- 单元测试

- 模拟请求测试

- 集成测试

- 源码解析

- 自动配置原理

- 启动流程分析

- 源码相关链接

- Servlet,Filter,Listener

- springcloud

- 配置

- 父pom

- 创建子工程

- Eureka

- Hystrix

- Ribbon

- Feign

- Zuul

- kotlin

- 基本数据类型

- 函数

- 区间

- 区块链

- 简介

- linux

- ulimit修改

- 防止syn攻击

- centos7部署bbr

- debain9开启bbr

- mysql

- 隔离性

- sql执行加载顺序

- 7种join

- explain

- 索引失效和优化

- 表连接优化

- orderby的filesort问题

- 慢查询

- show profile

- 全局查询日志

- 死锁解决

- sql

- 主从

- IDEA

- mac快捷键

- 美化界面

- 断点调试

- 重构

- springboot-devtools热部署

- IDEA进行JAR打包

- 导入jar包

- ProjectStructure

- toString添加json模板

- 配置maven

- Lombok插件

- rest client

- 文档显示

- sftp文件同步

- 书签

- 代码查看和搜索

- postfix

- live template

- git

- 文件头注释

- JRebel

- 离线模式

- xRebel

- github

- 连接mysql

- 选项没有Java class的解决方法

- 扩展

- 项目配置和web部署

- 前端开发

- json和Inject language

- idea内存和cpu变高

- 相关设置

- 设计模式

- 单例模式

- 简介

- 责任链

- JUC

- 原子类

- 原子类简介

- 基本类型原子类

- 数组类型原子类

- 引用类型原子类

- JVM

- JVM规范内存解析

- 对象的创建和结构

- 垃圾回收

- 内存分配策略

- 备注

- 虚拟机工具

- 内存模型

- 同步八种操作

- 内存区域大小参数设置

- happens-before

- web service

- tomcat

- HTTPS

- nginx

- 变量

- 运算符

- 模块

- Rewrite规则

- Netty

- netty为什么没用AIO

- 基本组件

- 源码解读

- 简单的socket例子

- 准备netty

- netty服务端启动

- 案例一:发送字符串

- 案例二:发送对象

- websocket

- ActiveMQ

- JMS

- 安装

- 生产者-消费者代码

- 整合springboot

- kafka

- 简介

- 安装

- 图形化界面

- 生产过程分析

- 保存消息分析

- 消费过程分析

- 命令行

- 生产者

- 消费者

- 拦截器interceptor

- partition

- kafka为什么快

- kafka streams

- kafka与flume整合

- RabbitMQ

- AMQP

- 整体架构

- RabbitMQ安装

- rpm方式安装

- 命令行和管控页面

- 消息生产与消费

- 整合springboot

- 依赖和配置

- 简单测试

- 多方测试

- 对象支持

- Topic Exchange模式

- Fanout Exchange订阅

- 消息确认

- java client

- RabbitAdmin和RabbitTemplate

- 两者简介

- RabbitmqAdmin

- RabbitTemplate

- SimpleMessageListenerContainer

- MessageListenerAdapter

- MessageConverter

- 详解

- Jackson2JsonMessageConverter

- ContentTypeDelegatingMessageConverter

- lucene

- 简介

- 入门程序

- luke查看索引

- 分析器

- 索引库维护

- elasticsearch

- 配置

- 插件

- head插件

- ik分词插件

- 常用术语

- Mapping映射

- 数据类型

- 属性方法

- Dynamic Mapping

- Index Template 索引模板

- 管理映射

- 建立映射

- 索引操作

- 单模式下CURD

- mget多个文档

- 批量操作

- 版本控制

- 基本查询

- Filter过滤

- 组合查询

- 分析器

- redis

- String

- list

- hash

- set

- sortedset

- 发布订阅

- 事务

- 连接池

- 管道

- 分布式可重入锁

- 配置文件翻译

- 持久化

- RDB

- AOF

- 总结

- Lettuce

- zookeeper

- zookeeper简介

- 集群部署

- Observer模式

- 核心工作机制

- zk命令行操作

- zk客户端API

- 感知服务动态上下线

- 分布式共享锁

- 原理

- zab协议

- 两阶段提交协议

- 三阶段提交协议

- Paxos协议

- ZAB协议

- hadoop

- 简介

- hadoop安装

- 集群安装

- 单机安装

- linux编译hadoop

- 添加新节点

- 退役旧节点

- 集群间数据拷贝

- 归档

- 快照管理

- 回收站

- 检查hdfs健康状态

- 安全模式

- hdfs简介

- hdfs命令行操作

- 常见问题汇总

- hdfs客户端操作

- mapreduce工作机制

- 案例-单词统计

- 局部聚合Combiner

- combiner流程

- combiner案例

- 自定义排序

- 自定义Bean对象

- 排序的分类

- 案例-按总量排序需求

- 一次性完成统计和排序

- 分区

- 分区简介

- 案例-结果分区

- 多表合并

- reducer端合并

- map端合并(分布式缓存)

- 分组

- groupingComparator

- 案例-求topN

- 全局计数器

- 合并小文件

- 小文件的弊端

- CombineTextInputFormat机制

- 自定义InputFormat

- 自定义outputFormat

- 多job串联

- 倒排索引

- 共同好友

- 串联

- 数据压缩

- InputFormat接口实现类

- yarn简介

- 推测执行算法

- 本地提交到yarn

- 框架运算全流程

- 数据倾斜问题

- mapreduce的优化方案

- HA机制

- 优化

- Hive

- 安装

- shell参数

- 数据类型

- 集合类型

- 数据库

- DDL操作

- 创建表

- 修改表

- 分区表

- 分桶表

- DML操作

- load

- insert

- select

- export,import

- Truncate

- 注意

- 严格模式

- 函数

- 内置运算符

- 内置函数

- 自定义函数

- Transfrom实现

- having和where不同

- 压缩

- 存储

- 存储和压缩结合使用

- explain详解

- 调优

- Fetch抓取

- 本地模式

- 表的优化

- GroupBy

- count(Distinct)去重统计

- 行列过滤

- 动态分区调整

- 数据倾斜

- 并行执行

- JVM重用

- 推测执行

- reduce内存和个数

- sql查询结果作为变量(shell)

- youtube

- flume

- 简介

- 安装

- 常用组件

- 拦截器

- 案例

- 监听端口到控制台

- 采集目录到HDFS

- 采集文件到HDFS

- 多个agent串联

- 日志采集和汇总

- 单flume多channel,sink

- 自定义拦截器

- 高可用配置

- 使用注意

- 监控Ganglia

- sqoop

- 安装

- 常用命令

- 数据导入

- 准备数据

- 导入数据到HDFS

- 导入关系表到HIVE

- 导入表数据子集

- 增量导入

- 数据导出

- 打包脚本

- 作业

- 原理

- azkaban

- 简介

- 安装

- 案例

- 简介

- command类型单一job

- command类型多job工作流flow

- HDFS操作任务

- mapreduce任务

- hive脚本任务

- oozie

- 安装

- hbase

- 简介

- 系统架构

- 物理存储

- 寻址机制

- 读写过程

- 安装

- 命令行

- 基本CURD

- java api

- CURD

- CAS

- 过滤器查询

- 建表高级属性

- 与mapreduce结合

- 与sqoop结合

- 协处理器

- 参数配置优化

- 数据备份和恢复

- 节点管理

- 案例-点击流

- 简介

- HUE

- 安装

- storm

- 简介

- 安装

- 集群启动及任务过程分析

- 单词统计

- 单词统计(接入kafka)

- 并行度和分组

- 启动流程分析

- ACK容错机制

- ACK简介

- BaseRichBolt简单使用

- BaseBasicBolt简单使用

- Ack工作机制

- 本地目录树

- zookeeper目录树

- 通信机制

- 案例

- 日志告警

- 工具

- YAPI

- chrome无法手动拖动安装插件

- 时间和空间复杂度

- jenkins

- 定位cpu 100%

- 常用脚本工具

- OOM问题定位

- scala

- 编译

- 基本语法

- 函数

- 数组常用方法

- 集合

- 并行集合

- 类

- 模式匹配

- 异常

- tuple元祖

- actor并发编程

- 柯里化

- 隐式转换

- 泛型

- 迭代器

- 流stream

- 视图view

- 控制抽象

- 注解

- spark

- 企业架构

- 安装

- api开发

- mycat

- Groovy

- 基础