# 三、如何保存和恢复训练模型

滚动浏览`reddit.com/r/learnmachinelearning`的帖子后,我意识到机器学习项目的主要瓶颈,出现于数据输入流水线和模型的最后阶段,你必须保存模型和 对新数据做出预测。 所以我认为制作一个简单直接的教程,向你展示如何保存和恢复使用 Tensorflow Eager 构建的模型会很有用。

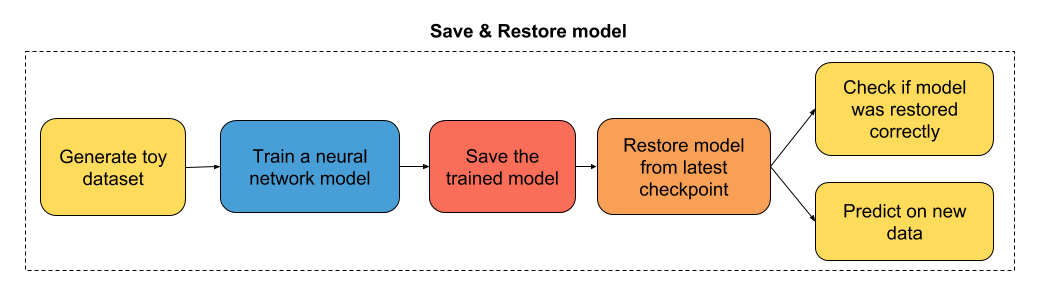

教程的流程图

## 导入有用的库

```py

# 导入 TensorFlow 和 TensorFlow Eager

import tensorflow as tf

import tensorflow.contrib.eager as tfe

# 导入函数来生成玩具分类问题

from sklearn.datasets import make_moons

# 开启 Eager 模式。一旦开启不能撤销!只执行一次。

tfe.enable_eager_execution()

```

## 第一部分:为二分类构建简单的神经网络

```py

class simple_nn(tf.keras.Model):

def __init__(self):

super(simple_nn, self).__init__()

""" 在这里定义正向传播期间

使用的神经网络层

"""

# 隐层

self.dense_layer = tf.layers.Dense(10, activation=tf.nn.relu)

# 输出层,无激活

self.output_layer = tf.layers.Dense(2, activation=None)

def predict(self, input_data):

""" 在神经网络上执行正向传播

Args:

input_data: 2D tensor of shape (n_samples, n_features).

Returns:

logits: unnormalized predictions.

"""

hidden_activations = self.dense_layer(input_data)

logits = self.output_layer(hidden_activations)

return logits

def loss_fn(self, input_data, target):

""" 定义训练期间使用的损失函数

"""

logits = self.predict(input_data)

loss = tf.losses.sparse_softmax_cross_entropy(labels=target, logits=logits)

return loss

def grads_fn(self, input_data, target):

""" 在每个正向步骤中,

动态计算损失值对模型参数的梯度

"""

with tfe.GradientTape() as tape:

loss = self.loss_fn(input_data, target)

return tape.gradient(loss, self.variables)

def fit(self, input_data, target, optimizer, num_epochs=500, verbose=50):

""" 用于训练模型的函数,

使用所选的优化器,执行所需数量的迭代

"""

for i in range(num_epochs):

grads = self.grads_fn(input_data, target)

optimizer.apply_gradients(zip(grads, self.variables))

if (i==0) | ((i+1)%verbose==0):

print('Loss at epoch %d: %f' %(i+1, self.loss_fn(input_data, target).numpy()))

```

## 第二部分:训练模型

```py

# 为分类生成玩具数据集

# X 是 n_samples x n_features 的矩阵,表示输入特征

# y 是 长度为 n_samples 的向量,表示我们的标签

X, y = make_moons(n_samples=100, noise=0.1, random_state=2018)

X_train, y_train = tf.constant(X[:80,:]), tf.constant(y[:80])

X_test, y_test = tf.constant(X[80:,:]), tf.constant(y[80:])

optimizer = tf.train.GradientDescentOptimizer(5e-1)

model = simple_nn()

model.fit(X_train, y_train, optimizer, num_epochs=500, verbose=50)

'''

Loss at epoch 1: 0.658276

Loss at epoch 50: 0.302146

Loss at epoch 100: 0.268594

Loss at epoch 150: 0.247425

Loss at epoch 200: 0.229143

Loss at epoch 250: 0.197839

Loss at epoch 300: 0.143365

Loss at epoch 350: 0.098039

Loss at epoch 400: 0.070781

Loss at epoch 450: 0.053753

Loss at epoch 500: 0.042401

'''

```

## 第三部分:保存训练模型

```py

# 指定检查点目录

checkpoint_directory = 'models_checkpoints/SimpleNN/'

# 创建模型检查点

checkpoint = tfe.Checkpoint(optimizer=optimizer,

model=model,

optimizer_step=tf.train.get_or_create_global_step())

# 保存训练模型

checkpoint.save(file_prefix=checkpoint_directory)

# 'models_checkpoints/SimpleNN/-1'

```

## 第四部分:恢复训练模型

```py

# 重新初始化模型实例

model = simple_nn()

optimizer = tf.train.GradientDescentOptimizer(5e-1)

# 指定检查点目录

checkpoint_directory = 'models_checkpoints/SimpleNN/'

# 创建模型检查点

checkpoint = tfe.Checkpoint(optimizer=optimizer,

model=model,

optimizer_step=tf.train.get_or_create_global_step())

# 从最近的检查点恢复模型

checkpoint.restore(tf.train.latest_checkpoint(checkpoint_directory))

# <tensorflow.contrib.eager.python.checkpointable_utils.CheckpointLoadStatus at 0x7fcfd47d2048>

```

## 第五部分:检查模型是否正确恢复

```py

model.fit(X_train, y_train, optimizer, num_epochs=1)

# Loss at epoch 1: 0.042220

```

损失似乎与我们在之前训练的最后一个迭代中获得的损失一致!

## 第六部分:对新数据做预测

```py

logits_test = model.predict(X_test)

print(logits_test)

'''

tf.Tensor(

[[ 1.54352813 -0.83117302]

[-1.60523365 2.82397487]

[ 2.87589525 -1.36463485]

[-1.39461001 2.62404279]

[ 0.82305161 -0.55651397]

[ 3.53674391 -2.55593046]

[-2.97344627 3.46589599]

[-1.69372442 2.95660466]

[-1.43226137 2.65357974]

[ 3.11479995 -1.31765645]

[-0.65841567 1.60468631]

[-2.27454367 3.60553595]

[-1.50170912 2.74410115]

[ 0.76261479 -0.44574208]

[ 2.34516959 -1.6859307 ]

[ 1.92181942 -1.63766352]

[ 4.06047684 -3.03988941]

[ 1.00252324 -0.78900484]

[ 2.79802993 -2.2139734 ]

[-1.43933035 2.68037059]], shape=(20, 2), dtype=float64)

'''

```

- TensorFlow 1.x 深度学习秘籍

- 零、前言

- 一、TensorFlow 简介

- 二、回归

- 三、神经网络:感知器

- 四、卷积神经网络

- 五、高级卷积神经网络

- 六、循环神经网络

- 七、无监督学习

- 八、自编码器

- 九、强化学习

- 十、移动计算

- 十一、生成模型和 CapsNet

- 十二、分布式 TensorFlow 和云深度学习

- 十三、AutoML 和学习如何学习(元学习)

- 十四、TensorFlow 处理单元

- 使用 TensorFlow 构建机器学习项目中文版

- 一、探索和转换数据

- 二、聚类

- 三、线性回归

- 四、逻辑回归

- 五、简单的前馈神经网络

- 六、卷积神经网络

- 七、循环神经网络和 LSTM

- 八、深度神经网络

- 九、大规模运行模型 -- GPU 和服务

- 十、库安装和其他提示

- TensorFlow 深度学习中文第二版

- 一、人工神经网络

- 二、TensorFlow v1.6 的新功能是什么?

- 三、实现前馈神经网络

- 四、CNN 实战

- 五、使用 TensorFlow 实现自编码器

- 六、RNN 和梯度消失或爆炸问题

- 七、TensorFlow GPU 配置

- 八、TFLearn

- 九、使用协同过滤的电影推荐

- 十、OpenAI Gym

- TensorFlow 深度学习实战指南中文版

- 一、入门

- 二、深度神经网络

- 三、卷积神经网络

- 四、循环神经网络介绍

- 五、总结

- 精通 TensorFlow 1.x

- 一、TensorFlow 101

- 二、TensorFlow 的高级库

- 三、Keras 101

- 四、TensorFlow 中的经典机器学习

- 五、TensorFlow 和 Keras 中的神经网络和 MLP

- 六、TensorFlow 和 Keras 中的 RNN

- 七、TensorFlow 和 Keras 中的用于时间序列数据的 RNN

- 八、TensorFlow 和 Keras 中的用于文本数据的 RNN

- 九、TensorFlow 和 Keras 中的 CNN

- 十、TensorFlow 和 Keras 中的自编码器

- 十一、TF 服务:生产中的 TensorFlow 模型

- 十二、迁移学习和预训练模型

- 十三、深度强化学习

- 十四、生成对抗网络

- 十五、TensorFlow 集群的分布式模型

- 十六、移动和嵌入式平台上的 TensorFlow 模型

- 十七、R 中的 TensorFlow 和 Keras

- 十八、调试 TensorFlow 模型

- 十九、张量处理单元

- TensorFlow 机器学习秘籍中文第二版

- 一、TensorFlow 入门

- 二、TensorFlow 的方式

- 三、线性回归

- 四、支持向量机

- 五、最近邻方法

- 六、神经网络

- 七、自然语言处理

- 八、卷积神经网络

- 九、循环神经网络

- 十、将 TensorFlow 投入生产

- 十一、更多 TensorFlow

- 与 TensorFlow 的初次接触

- 前言

- 1. TensorFlow 基础知识

- 2. TensorFlow 中的线性回归

- 3. TensorFlow 中的聚类

- 4. TensorFlow 中的单层神经网络

- 5. TensorFlow 中的多层神经网络

- 6. 并行

- 后记

- TensorFlow 学习指南

- 一、基础

- 二、线性模型

- 三、学习

- 四、分布式

- TensorFlow Rager 教程

- 一、如何使用 TensorFlow Eager 构建简单的神经网络

- 二、在 Eager 模式中使用指标

- 三、如何保存和恢复训练模型

- 四、文本序列到 TFRecords

- 五、如何将原始图片数据转换为 TFRecords

- 六、如何使用 TensorFlow Eager 从 TFRecords 批量读取数据

- 七、使用 TensorFlow Eager 构建用于情感识别的卷积神经网络(CNN)

- 八、用于 TensorFlow Eager 序列分类的动态循坏神经网络

- 九、用于 TensorFlow Eager 时间序列回归的递归神经网络

- TensorFlow 高效编程

- 图嵌入综述:问题,技术与应用

- 一、引言

- 三、图嵌入的问题设定

- 四、图嵌入技术

- 基于边重构的优化问题

- 应用

- 基于深度学习的推荐系统:综述和新视角

- 引言

- 基于深度学习的推荐:最先进的技术

- 基于卷积神经网络的推荐

- 关于卷积神经网络我们理解了什么

- 第1章概论

- 第2章多层网络

- 2.1.4生成对抗网络

- 2.2.1最近ConvNets演变中的关键架构

- 2.2.2走向ConvNet不变性

- 2.3时空卷积网络

- 第3章了解ConvNets构建块

- 3.2整改

- 3.3规范化

- 3.4汇集

- 第四章现状

- 4.2打开问题

- 参考

- 机器学习超级复习笔记

- Python 迁移学习实用指南

- 零、前言

- 一、机器学习基础

- 二、深度学习基础

- 三、了解深度学习架构

- 四、迁移学习基础

- 五、释放迁移学习的力量

- 六、图像识别与分类

- 七、文本文件分类

- 八、音频事件识别与分类

- 九、DeepDream

- 十、自动图像字幕生成器

- 十一、图像着色

- 面向计算机视觉的深度学习

- 零、前言

- 一、入门

- 二、图像分类

- 三、图像检索

- 四、对象检测

- 五、语义分割

- 六、相似性学习

- 七、图像字幕

- 八、生成模型

- 九、视频分类

- 十、部署

- 深度学习快速参考

- 零、前言

- 一、深度学习的基础

- 二、使用深度学习解决回归问题

- 三、使用 TensorBoard 监控网络训练

- 四、使用深度学习解决二分类问题

- 五、使用 Keras 解决多分类问题

- 六、超参数优化

- 七、从头开始训练 CNN

- 八、将预训练的 CNN 用于迁移学习

- 九、从头开始训练 RNN

- 十、使用词嵌入从头开始训练 LSTM

- 十一、训练 Seq2Seq 模型

- 十二、深度强化学习

- 十三、生成对抗网络

- TensorFlow 2.0 快速入门指南

- 零、前言

- 第 1 部分:TensorFlow 2.00 Alpha 简介

- 一、TensorFlow 2 简介

- 二、Keras:TensorFlow 2 的高级 API

- 三、TensorFlow 2 和 ANN 技术

- 第 2 部分:TensorFlow 2.00 Alpha 中的监督和无监督学习

- 四、TensorFlow 2 和监督机器学习

- 五、TensorFlow 2 和无监督学习

- 第 3 部分:TensorFlow 2.00 Alpha 的神经网络应用

- 六、使用 TensorFlow 2 识别图像

- 七、TensorFlow 2 和神经风格迁移

- 八、TensorFlow 2 和循环神经网络

- 九、TensorFlow 估计器和 TensorFlow HUB

- 十、从 tf1.12 转换为 tf2

- TensorFlow 入门

- 零、前言

- 一、TensorFlow 基本概念

- 二、TensorFlow 数学运算

- 三、机器学习入门

- 四、神经网络简介

- 五、深度学习

- 六、TensorFlow GPU 编程和服务

- TensorFlow 卷积神经网络实用指南

- 零、前言

- 一、TensorFlow 的设置和介绍

- 二、深度学习和卷积神经网络

- 三、TensorFlow 中的图像分类

- 四、目标检测与分割

- 五、VGG,Inception,ResNet 和 MobileNets

- 六、自编码器,变分自编码器和生成对抗网络

- 七、迁移学习

- 八、机器学习最佳实践和故障排除

- 九、大规模训练

- 十、参考文献