与 RDDs 类似,转换允许修改输入 DStream 中的数据。DStreams 支持许多在普通 Spark RDD 上可用的转换。一些常见的转换操作定义如下。

<br/>

**map(func):** 通过函数 func 传递源 DStream 的每个元素来返回一个新的DStream。

**flatMap(func):** 与 map 类似,但是每个输入项可以映射到 0 或多个输出项。

**filter(func):** 通过只选择 func 返回 true 的源 DStream 的记录来返回一个新的 DStream。

**repartition(numPartitions):** 通过创建更多或更少的分区来改变 DStream 中的并行度。

**union(otherStream):** 返回一个新的 DStream,它包含源 DStream 和otherDStream 中元素的并集。

**count():** 通过计算源 DStream 的每个 RDD 中的元素数量,返回一个新的单元素 RDDs DStream。

**reduce(func):** 通过使用函数 func(接受两个参数并返回一个参数)聚合源DStream 的每个 RDD 中的元素,返回一个新的单元素 RDDs DStream。这个函数应该是结合律和交换律,这样才能并行计算。

**countByValue():** 当对类型为 K 的元素的 DStream 调用时,返回一个新的 DStream (K,Long)对,其中每个键的值是它在源 DStream 的每个 RDD中的频率。

**reduceByKey(func, [numTasks]):** 当在(K, V)对的 DStream 上调用时,返回一个新的(K, V)对的 DStream,其中每个键的值使用给定的 reduce 函数进行聚合。注意:在默认情况下,这将使用 Spark 的默认并行任务数(本地模式为 2,而在集群模式下,该数量由配置属性 spark.default.parallelism决定)来进行分组。可以传递一个可选的 numTasks 参数来设置不同数量的任务。

**join(otherStream, [numTasks]):** 当调用两个 DStream (K, V)和(K, W)对时,返回一个新的 DStream (K,(V, W))对,每个键的所有对的元素。

**cogroup(otherStream, [numTasks]):** 当调用(K, V)和(K, W)对的 DStream 时,返回一个新的(K, Seq[V],Seq[W])元组 DStream。

**transform(func):** 通过对源 DStream 的每个 RDD 应用一个 RDD-to-RDD函数来返回一个新的 DStream。这可以用来在 DStream 上执行任意的RDD 操作。

**updateStateByKey(func):** 返回一个新的“状态”DStream,其中通过对键的前一个状态和键的新值应用给定的函数来更新每个键的状态。这可以用来维护每个键的任意状态数据。

<br/>

相比RDD转换,DStream有两个特殊操作:updateStateByKey操作和window操作。

<br/>

# 1. updateStateByKey 操作

updateStateByKey 操作允许维护任意状态,同时不断地用新信息更新它。要使用它,必须执行两个步骤。

(1)定义状态——状态可以是任意的数据类型。

(2)定义状态更新函数——使用一个函数指定如何使用输入流中的前一个状态和新值来更新状态。

<br/>

在每个批处理中,Spark 将对所有现有 keys 应用<mark>状态更新</mark>功能,而不管它们在批处理中是否有新数据。如果更新函数返回 None,则键值对将被删除。

<br/>

例如:需要维护在整个文本数据流中看到的每个单词的运行计数。这里,运行计数是状态,它是一个整数。将更新函数定义如下:

```scala

// 将更新函数

def updateFunction(newValues: Seq[Int],

runningCount: Option[Int]): Option[Int] = {

val newCount = ... //使用前一个运行的计数添加新值以获得新计数

Some(newCount)

}

// 函数调用示例:

val runningCounts = pairs.updateStateByKey[Int](updateFunction _)

```

<br/>

完整代码:

```scala

import org.apache.spark.SparkConf

import org.apache.spark.streaming.{Seconds, StreamingContext}

/**

* 使用 Spark Streaming 处理有状态的数据

*/

object StatefulWordCount {

def main(args: Array[String]) {

val sparkConf = new SparkConf

sparkConf.setAppName("StatefulWordCount").setMaster("local[2]")

val ssc = new StreamingContext(sparkConf, Seconds(5))

ssc.checkpoint(".")

val lines = ssc.socketTextStream("localhost", 6789)

val result = lines.flatMap(_.split(" ")).map((_, 1))

val state = result.updateStateByKey(updateFunction)

state.print()

ssc.start()

ssc.awaitTermination()

}

def updateFunction(currentValues: Seq[Int],

preValues: Option[Int]): Option[Int] = {

val curr = currentValues.sum

val pre = preValues.getOrElse(0)

Some(curr + pre)

}

}

```

<br/>

# 2. window操作

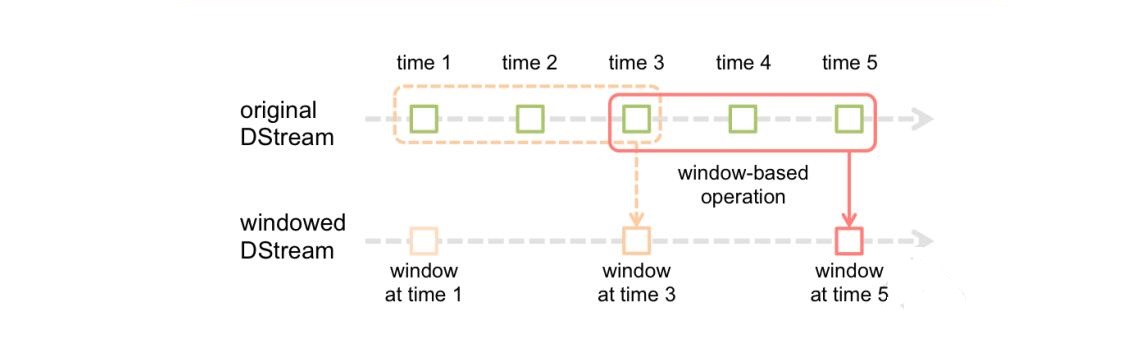

Spark Streaming 还提供了窗口计算,它允许在数据的滑动窗口上应用转换。下图演示了这个滑动窗口。

:-:

滑动窗口

<br/>

如图所示,每当窗口在源 DStream 上滑动时,位于窗口内的源 RDDs 就会被合并并操作,以生成窗口化的 DStream 的 RDDs。在本例中,操作应用于数据的最后 3 个时间单位,幻灯片应用于 2 个时间单位。这表明任何窗口操作都需要指定两个参数。

* 窗口长度—窗口的持续时间(图中为 3)。

* 滑动间隔—窗口操作执行的间隔(图中为 2)。

这两个参数必须是源 DStream 的批处理间隔的倍数(图中为 1)。

<br/>

例如,希望通过每 10 秒在最后 30 秒的数据中生成单词计数来扩展前面的示例。为此,必须在最后 30 秒的数据中对(word, 1)的 DStream 应用 reduceByKey操作,可以使用 reduceByKeyAndWindow 操作完成。

```scala

//每 10 秒对最后 30 秒的数据进行 reduceByKey

val windowedWordCounts = pairs.reduceByKeyAndWindow(

(a:Int,b:Int) => (a + b), Seconds(30), Seconds(10))

```

<br/>

还有一种更通用的方式:`window(windowLength, slideInterval)`。下述代码效果与上面相同。

```scala

val ssc = new StreamingContext(sc, Seconds(1))

val lines = ssc.socketTextStream("localhost",6789)

val words = lines.window(Seconds(30),Seconds(10)).flatMap(_.split(" "))

val wordCounts = words.map(x => (x, 1)).reduceByKey(_ + _)

wordCounts.print()

ssc.start()

```

- Hadoop

- hadoop是什么?

- Hadoop组成

- hadoop官网

- hadoop安装

- hadoop配置

- 本地运行模式配置

- 伪分布运行模式配置

- 完全分布运行模式配置

- HDFS分布式文件系统

- HDFS架构

- HDFS设计思想

- HDFS组成架构

- HDFS文件块大小

- HDFS优缺点

- HDFS Shell操作

- HDFS JavaAPI

- 基本使用

- HDFS的I/O 流操作

- 在SpringBoot项目中的API

- HDFS读写流程

- HDFS写流程

- HDFS读流程

- NN和SNN关系

- NN和SNN工作机制

- Fsimage和 Edits解析

- checkpoint时间设置

- NameNode故障处理

- 集群安全模式

- DataNode工作机制

- 支持的文件格式

- MapReduce分布式计算模型

- MapReduce是什么?

- MapReduce设计思想

- MapReduce优缺点

- MapReduce基本使用

- MapReduce编程规范

- WordCount案例

- MapReduce任务进程

- Hadoop序列化对象

- 为什么要序列化

- 常用数据序列化类型

- 自定义序列化对象

- MapReduce框架原理

- MapReduce工作流程

- MapReduce核心类

- MapTask工作机制

- Shuffle机制

- Partition分区

- Combiner合并

- ReduceTask工作机制

- OutputFormat

- 使用MapReduce实现SQL Join操作

- Reduce join

- Reduce join 代码实现

- Map join

- Map join 案例实操

- MapReduce 开发总结

- Hadoop 优化

- MapReduce 优化需要考虑的点

- MapReduce 优化方法

- 分布式资源调度框架 Yarn

- Yarn 基本架构

- ResourceManager(RM)

- NodeManager(NM)

- ApplicationMaster

- Container

- 作业提交全过程

- JobHistoryServer 使用

- 资源调度器

- 先进先出调度器(FIFO)

- 容量调度器(Capacity Scheduler)

- 公平调度器(Fair Scheduler)

- Yarn 常用命令

- Zookeeper

- zookeeper是什么?

- zookeeper完全分布式搭建

- Zookeeper特点

- Zookeeper数据结构

- Zookeeper 内部原理

- 选举机制

- stat 信息中字段解释

- 选择机制中的概念

- 选举消息内容

- 监听器原理

- Hadoop 高可用集群搭建

- Zookeeper 应用

- Zookeeper Shell操作

- Zookeeper Java应用

- Hive

- Hive是什么?

- Hive的优缺点

- Hive架构

- Hive元数据存储模式

- 内嵌模式

- 本地模式

- 远程模式

- Hive环境搭建

- 伪分布式环境搭建

- Hive命令工具

- 命令行模式

- 交互模式

- Hive数据类型

- Hive数据结构

- 参数配置方式

- Hive数据库

- 数据库存储位置

- 数据库操作

- 表的创建

- 建表基本语法

- 内部表

- 外部表

- 临时表

- 建表高阶语句

- 表的删除与修改

- 分区表

- 静态分区

- 动态分区

- 分桶表

- 创建分桶表

- 分桶抽样

- Hive视图

- 视图的创建

- 侧视图Lateral View

- Hive数据导入导出

- 导入数据

- 导出数据

- 查询表数据量

- Hive事务

- 事务是什么?

- Hive事务的局限性和特点

- Hive事务的开启和设置

- Hive PLSQL

- Hive高阶查询

- 查询基本语法

- 基本查询

- distinct去重

- where语句

- 列正则表达式

- 虚拟列

- CTE查询

- 嵌套查询

- join语句

- 内连接

- 左连接

- 右连接

- 全连接

- 多表连接

- 笛卡尔积

- left semi join

- group by分组

- having刷选

- union与union all

- 排序

- order by

- sort by

- distribute by

- cluster by

- 聚合运算

- 基本聚合

- 高级聚合

- 窗口函数

- 序列窗口函数

- 聚合窗口函数

- 分析窗口函数

- 窗口函数练习

- 窗口子句

- Hive函数

- Hive函数分类

- 字符串函数

- 类型转换函数

- 数学函数

- 日期函数

- 集合函数

- 条件函数

- 聚合函数

- 表生成函数

- 自定义Hive函数

- 自定义函数分类

- 自定义Hive函数流程

- 添加JAR包的方式

- 自定义临时函数

- 自定义永久函数

- Hive优化

- Hive性能调优工具

- EXPLAIN

- ANALYZE

- Fetch抓取

- 本地模式

- 表的优化

- 小表 join 大表

- 大表 join 大表

- 开启Map Join

- group by

- count(distinct)

- 笛卡尔积

- 行列过滤

- 动态分区调整

- 分区分桶表

- 数据倾斜

- 数据倾斜原因

- 调整Map数

- 调整Reduce数

- 产生数据倾斜的场景

- 并行执行

- 严格模式

- JVM重用

- 推测执行

- 启用CBO

- 启动矢量化

- 使用Tez引擎

- 压缩算法和文件格式

- 文件格式

- 压缩算法

- Zeppelin

- Zeppelin是什么?

- Zeppelin安装

- 配置Hive解释器

- Hbase

- Hbase是什么?

- Hbase环境搭建

- Hbase分布式环境搭建

- Hbase伪分布式环境搭建

- Hbase架构

- Hbase架构组件

- Hbase数据存储结构

- Hbase原理

- Hbase Shell

- 基本操作

- 表操作

- namespace

- Hbase Java Api

- Phoenix集成Hbase

- Phoenix是什么?

- 安装Phoenix

- Phoenix数据类型

- Phoenix Shell

- HBase与Hive集成

- HBase与Hive的对比

- HBase与Hive集成使用

- Hbase与Hive集成原理

- HBase优化

- RowKey设计

- 内存优化

- 基础优化

- Hbase管理

- 权限管理

- Region管理

- Region的自动拆分

- Region的预拆分

- 到底采用哪种拆分策略?

- Region的合并

- HFile的合并

- 为什么要有HFile的合并

- HFile合并方式

- Compaction执行时间

- Compaction相关控制参数

- 演示示例

- Sqoop

- Sqoop是什么?

- Sqoop环境搭建

- RDBMS导入到HDFS

- RDBMS导入到Hive

- RDBMS导入到Hbase

- HDFS导出到RDBMS

- 使用sqoop脚本

- Sqoop常用命令

- Hadoop数据模型

- TextFile

- SequenceFile

- Avro

- Parquet

- RC&ORC

- 文件存储格式比较

- Spark

- Spark是什么?

- Spark优势

- Spark与MapReduce比较

- Spark技术栈

- Spark安装

- Spark Shell

- Spark架构

- Spark编程入口

- 编程入口API

- SparkContext

- SparkSession

- Spark的maven依赖

- Spark RDD编程

- Spark核心数据结构-RDD

- RDD 概念

- RDD 特性

- RDD编程

- RDD编程流程

- pom依赖

- 创建算子

- 转换算子

- 动作算子

- 持久化算子

- RDD 与闭包

- csv/json数据源

- Spark分布式计算原理

- RDD依赖

- RDD转换

- RDD依赖

- DAG工作原理

- Spark Shuffle原理

- Shuffle的作用

- ShuffleManager组件

- Shuffle实践

- RDD持久化

- 缓存机制

- 检查点

- 检查点与缓存的区别

- RDD共享变量

- 广播变量

- 累计器

- RDD分区设计

- 数据倾斜

- 数据倾斜的根本原因

- 定位导致的数据倾斜

- 常见数据倾斜解决方案

- Spark SQL

- SQL on Hadoop

- Spark SQL是什么

- Spark SQL特点

- Spark SQL架构

- Spark SQL运行原理

- Spark SQL编程

- Spark SQL编程入口

- 创建Dataset

- Dataset是什么

- SparkSession创建Dataset

- 样例类创建Dataset

- 创建DataFrame

- DataFrame是什么

- 结构化数据文件创建DataFrame

- RDD创建DataFrame

- Hive表创建DataFrame

- JDBC创建DataFrame

- SparkSession创建

- RDD、DataFrame、Dataset

- 三者对比

- 三者相互转换

- RDD转换为DataFrame

- DataFrame转换为RDD

- DataFrame API

- DataFrame API分类

- Action 操作

- 基础 Dataset 函数

- 强类型转换

- 弱类型转换

- Spark SQL外部数据源

- Parquet文件

- Hive表

- RDBMS表

- JSON/CSV

- Spark SQL函数

- Spark SQL内置函数

- 自定SparkSQL函数

- Spark SQL CLI

- Spark SQL性能优化

- Spark GraphX图形数据分析

- 为什么需要图计算

- 图的概念

- 图的术语

- 图的经典表示法

- Spark Graphix简介

- Graphx核心抽象

- Graphx Scala API

- 核心组件

- 属性图应用示例1

- 属性图应用示例2

- 查看图信息

- 图的算子

- 连通分量

- PageRank算法

- Pregel分布式计算框架

- Flume日志收集

- Flume是什么?

- Flume官方文档

- Flume架构

- Flume安装

- Flume使用过程

- Flume组件

- Flume工作流程

- Flume事务

- Source、Channel、Sink文档

- Source文档

- Channel文档

- Sink文档

- Flume拦截器

- Flume拦截器概念

- 配置拦截器

- 自定义拦截器

- Flume可靠性保证

- 故障转移

- 负载均衡

- 多层代理

- 多路复用

- Kafka

- 消息中间件MQ

- Kafka是什么?

- Kafka安装

- Kafka本地单机部署

- Kafka基本命令使用

- Topic的生产与消费

- 基本命令

- 查看kafka目录

- Kafka架构

- Kafka Topic

- Kafka Producer

- Kafka Consumer

- Kafka Partition

- Kafka Message

- Kafka Broker

- 存储策略

- ZooKeeper在Kafka中的作用

- 副本同步

- 容灾

- 高吞吐

- Leader均衡机制

- Kafka Scala API

- Producer API

- Consumer API

- Kafka优化

- 消费者参数优化

- 生产者参数优化

- Spark Streaming

- 什么是流?

- 批处理和流处理

- Spark Streaming简介

- 流数据处理架构

- 内部工作流程

- StreamingContext组件

- SparkStreaming的编程入口

- WordCount案例

- DStream

- DStream是什么?

- Input DStream与Receivers接收器

- DStream API

- 转换操作

- 输出操作

- 数据源

- 数据源分类

- Socket数据源

- 统计HDFS文件的词频

- 处理状态数据

- SparkStreaming整合SparkSQL

- SparkStreaming整合Flume

- SparkStreaming整合Kafka

- 自定义数据源

- Spark Streaming优化策略

- 优化运行时间

- 优化内存使用

- 数据仓库

- 数据仓库是什么?

- 数据仓库的意义

- 数据仓库和数据库的区别

- OLTP和OLAP的区别

- OLTP的特点

- OLAP的特点

- OLTP与OLAP对比

- 数据仓库架构

- Inmon架构

- Kimball架构

- 混合型架构

- 数据仓库的解决方案

- 数据ETL

- 数据仓库建模流程

- 维度模型

- 星型模式

- 雪花模型

- 星座模型

- 数据ETL处理

- 数仓分层术语

- 数据抽取方式

- CDC抽取方案

- 数据转换

- 常见的ETL工具