#合并段

通过每秒自动刷新创建新的段,用不了多久段的数量就爆炸了。有太多的段是一个问题。每个段消费文件句柄,内存,cpu资源。更重要的是,每次搜索请求都需要依次检查每个段。段越多,查询越慢。

ES通过后台合并段解决这个问题。小段被合并成大段,再合并成更大的段。

这是旧的文档从文件系统删除的时候。旧的段不会再复制到更大的新段中。

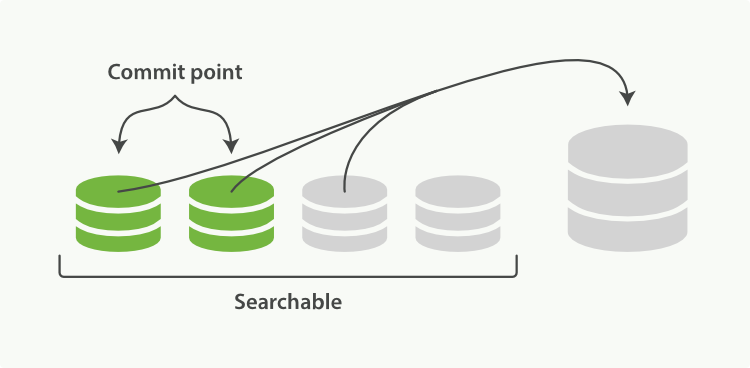

这个过程你不必做什么。当你在索引和搜索时ES会自动处理。这个过程如图:两个提交的段和一个未提交的段合并为了一个更大的段所示:

1. 索引过程中,refresh会创建新的段,并打开它。

2. 合并过程会在后台选择一些小的段合并成大的段,这个过程不会中断索引和搜索。

**图1:两个提交的段和一个未提交的段合并为了一个更大的段**

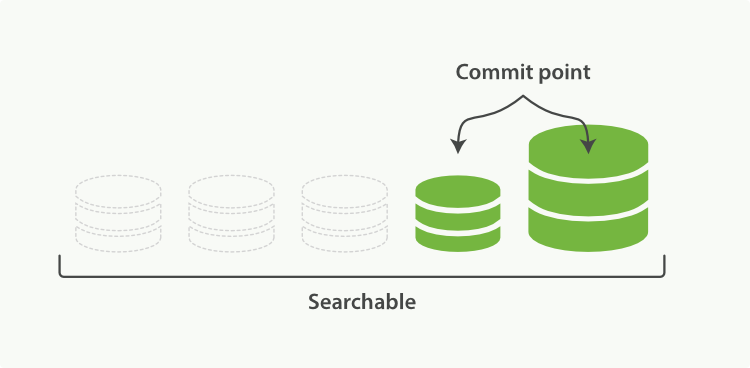

3. 下图描述了合并后的操作:

* 新的段flush到了硬盘。

* 新的提交点写入新的段,排除旧的段。

* 新的段打开供搜索。

* 旧的段被删除。

**图2:段合并完后,旧的段被删除**

合并大的段会消耗很多IO和CPU,如果不检查会影响到搜素性能。默认情况下,ES会限制合并过程,这样搜索就可以有足够的资源进行。

##optimize API

`optimize API`最好描述为强制合并段API。它强制分片合并段以达到指定`max_num_segments`参数。这是为了减少段的数量(通常为1)达到提高搜索性能的目的。

>警告

>不要在动态的索引(正在活跃更新)上使用`optimize API`。后台的合并处理已经做的很好了,优化命令会阻碍它的工作。不要干涉!

在特定的环境下,`optimize API`是有用的。典型的场景是记录日志,这中情况下日志是按照每天,周,月存入索引。旧的索引一般是只可读的,它们是不可能修改的。

这种情况下,把每个索引的段降至1是有效的。搜索过程就会用到更少的资源,性能更好:

```Javascript

POST /logstash-2014-10/_optimize?max_num_segments=1 <1>

```

- <1> 把索引中的每个分片都合并成一个段

- Introduction

- 入门

- 是什么

- 安装

- API

- 文档

- 索引

- 搜索

- 聚合

- 小结

- 分布式

- 结语

- 分布式集群

- 空集群

- 集群健康

- 添加索引

- 故障转移

- 横向扩展

- 更多扩展

- 应对故障

- 数据

- 文档

- 索引

- 获取

- 存在

- 更新

- 创建

- 删除

- 版本控制

- 局部更新

- Mget

- 批量

- 结语

- 分布式增删改查

- 路由

- 分片交互

- 新建、索引和删除

- 检索

- 局部更新

- 批量请求

- 批量格式

- 搜索

- 空搜索

- 多索引和多类型

- 分页

- 查询字符串

- 映射和分析

- 数据类型差异

- 确切值对决全文

- 倒排索引

- 分析

- 映射

- 复合类型

- 结构化查询

- 请求体查询

- 结构化查询

- 查询与过滤

- 重要的查询子句

- 过滤查询

- 验证查询

- 结语

- 排序

- 排序

- 字符串排序

- 相关性

- 字段数据

- 分布式搜索

- 查询阶段

- 取回阶段

- 搜索选项

- 扫描和滚屏

- 索引管理

- 创建删除

- 设置

- 配置分析器

- 自定义分析器

- 映射

- 根对象

- 元数据中的source字段

- 元数据中的all字段

- 元数据中的ID字段

- 动态映射

- 自定义动态映射

- 默认映射

- 重建索引

- 别名

- 深入分片

- 使文本可以被搜索

- 动态索引

- 近实时搜索

- 持久化变更

- 合并段

- 结构化搜索

- 查询准确值

- 组合过滤

- 查询多个准确值

- 包含,而不是相等

- 范围

- 处理 Null 值

- 缓存

- 过滤顺序

- 全文搜索

- 匹配查询

- 多词查询

- 组合查询

- 布尔匹配

- 增加子句

- 控制分析

- 关联失效

- 多字段搜索

- 多重查询字符串

- 单一查询字符串

- 最佳字段

- 最佳字段查询调优

- 多重匹配查询

- 最多字段查询

- 跨字段对象查询

- 以字段为中心查询

- 全字段查询

- 跨字段查询

- 精确查询

- 模糊匹配

- Phrase matching

- Slop

- Multi value fields

- Scoring

- Relevance

- Performance

- Shingles

- Partial_Matching

- Postcodes

- Prefix query

- Wildcard Regexp

- Match phrase prefix

- Index time

- Ngram intro

- Search as you type

- Compound words

- Relevance

- Scoring theory

- Practical scoring

- Query time boosting

- Query scoring

- Not quite not

- Ignoring TFIDF

- Function score query

- Popularity

- Boosting filtered subsets

- Random scoring

- Decay functions

- Pluggable similarities

- Conclusion

- Language intro

- Intro

- Using

- Configuring

- Language pitfalls

- One language per doc

- One language per field

- Mixed language fields

- Conclusion

- Identifying words

- Intro

- Standard analyzer

- Standard tokenizer

- ICU plugin

- ICU tokenizer

- Tidying text

- Token normalization

- Intro

- Lowercasing

- Removing diacritics

- Unicode world

- Case folding

- Character folding

- Sorting and collations

- Stemming

- Intro

- Algorithmic stemmers

- Dictionary stemmers

- Hunspell stemmer

- Choosing a stemmer

- Controlling stemming

- Stemming in situ

- Stopwords

- Intro

- Using stopwords

- Stopwords and performance

- Divide and conquer

- Phrase queries

- Common grams

- Relevance

- Synonyms

- Intro

- Using synonyms

- Synonym formats

- Expand contract

- Analysis chain

- Multi word synonyms

- Symbol synonyms

- Fuzzy matching

- Intro

- Fuzziness

- Fuzzy query

- Fuzzy match query

- Scoring fuzziness

- Phonetic matching

- Aggregations

- overview

- circuit breaker fd settings

- filtering

- facets

- docvalues

- eager

- breadth vs depth

- Conclusion

- concepts buckets

- basic example

- add metric

- nested bucket

- extra metrics

- bucket metric list

- histogram

- date histogram

- scope

- filtering

- sorting ordering

- approx intro

- cardinality

- percentiles

- sigterms intro

- sigterms

- fielddata

- analyzed vs not

- 地理坐标点

- 地理坐标点

- 通过地理坐标点过滤

- 地理坐标盒模型过滤器

- 地理距离过滤器

- 缓存地理位置过滤器

- 减少内存占用

- 按距离排序

- Geohashe

- Geohashe

- Geohashe映射

- Geohash单元过滤器

- 地理位置聚合

- 地理位置聚合

- 按距离聚合

- Geohash单元聚合器

- 范围(边界)聚合器

- 地理形状

- 地理形状

- 映射地理形状

- 索引地理形状

- 查询地理形状

- 在查询中使用已索引的形状

- 地理形状的过滤与缓存

- 关系

- 关系

- 应用级别的Join操作

- 扁平化你的数据

- Top hits

- Concurrency

- Concurrency solutions

- 嵌套

- 嵌套对象

- 嵌套映射

- 嵌套查询

- 嵌套排序

- 嵌套集合

- Parent Child

- Parent child

- Indexing parent child

- Has child

- Has parent

- Children agg

- Grandparents

- Practical considerations

- Scaling

- Shard

- Overallocation

- Kagillion shards

- Capacity planning

- Replica shards

- Multiple indices

- Index per timeframe

- Index templates

- Retiring data

- Index per user

- Shared index

- Faking it

- One big user

- Scale is not infinite

- Cluster Admin

- Marvel

- Health

- Node stats

- Other stats

- Deployment

- hardware

- other

- config

- dont touch

- heap

- file descriptors

- conclusion

- cluster settings

- Post Deployment

- dynamic settings

- logging

- indexing perf

- rolling restart

- backup

- restore

- conclusion