### 前言

互联网公司中,绝大部分都没有马爸爸系列的公司那样财大气粗,他们即没有强劲的服务器、也没有钱去购买昂贵的海量数据库。那他们是怎么应对大数据量高并发的业务场景的呢?

这个和当前的开源技术、海量数据架构都有着不可分割的关系。比如通过mysql、nginx等开源软件,通过架构和低成本的服务器搭建千万级别的用户访问系统。

怎么样搭建一个好的系统架构,这个话题我们能聊上个七天七夜。这里我主要结合Redis集群来讲一下一致性Hash的相关问题。

### Redis集群的使用

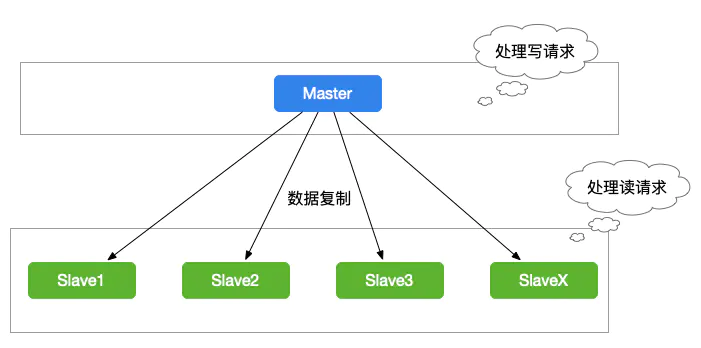

我们在使用Redis的过程中,为了保证Redis的高可用,我们一般会对Redis做主从复制,组成`Master-Master`或者`Master-Slave`的形式,进行数据的读写分离,如下图1-1所示:

图1-1:Master-Slave模式

当缓存数据量超过一定的数量时,我们就要对Redis集群做分库分表的操作。

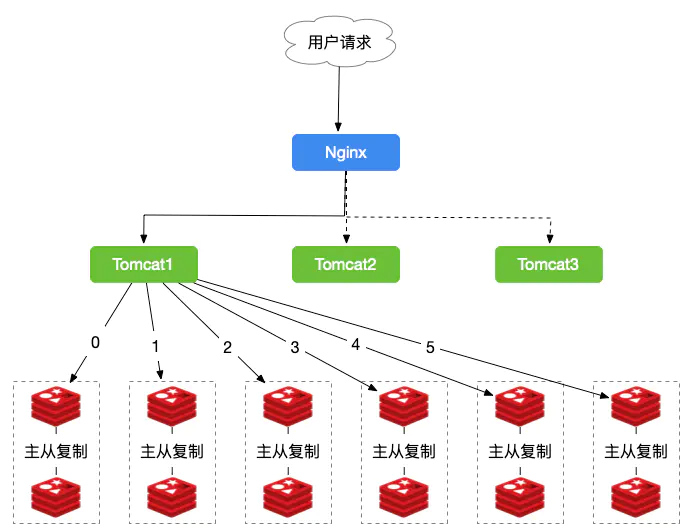

来个栗子,我们有一个电商平台,需要使用Redis存储商品的图片资源,存储的格式为键值对,key值为图片名称,Value为该图片所在的文件服务器的路径,我们需要根据文件名,查找到文件所在的文件服务器上的路径,我们的图片数量大概在3000w左右,按照我们的规则进行分库,规则就是随机分配的,我们以每台服务器存500w的数量,部署12台缓存服务器,并且进行主从复制,架构图如下图1-2所示:

图1-2:Redis分库分表

由于我们定义的规则是随机的,所以我们的数据有可能存储在任何一组Redis中,比如我们需要查询"product.png"的图片,由于规则的随机性,我们需要遍历所有Redis服务器,才能查询得到。这样的结果显然不是我们所需要的。所以我们会想到按某一个字段值进行Hash值、取模。所以我们就看看使用Hash的方式是怎么进行的。

### 使用Hash的Redis集群

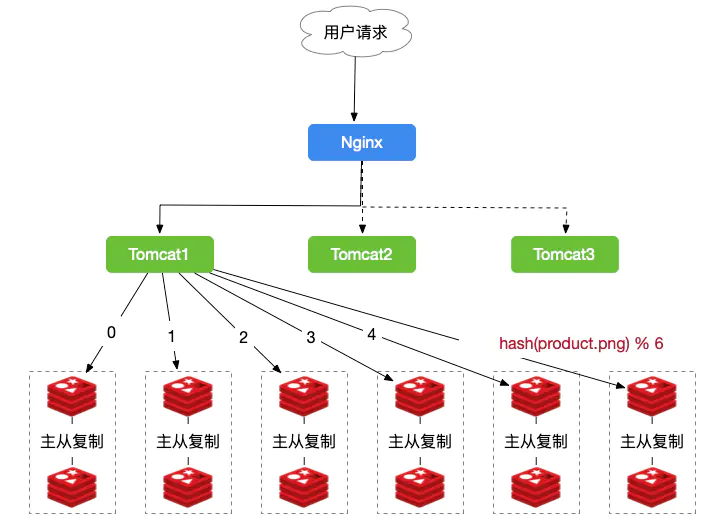

如果我们使用Hash的方式,每一张图片在进行分库的时候都可以定位到特定的服务器,示意图如图1-3所示:

图1-3:使用Hash方式的命中缓存

从上图中,我们需要查询的是图`product.png`,由于我们有6台主服务器,所以计算的公式为:`hash(product.png) % 6 = 5`, 我们就可以定位到是5号主从,这们就省去了遍历所有服务器的时间,从而大大提升了性能。

### 使用Hash时遇到的问题

在上述hash取模的过程中,我们虽然不需要对所有Redis服务器进行遍历而提升了性能。但是,使用Hash算法缓存时会出现一些问题,`Redis服务器变动时,所有缓存的位置都会发生改变`。

比如,现在我们的Redis缓存服务器增加到了8台,我们计算的公式从`hash(product.png) % 6 = 5`变成了`hash(product.png) % 8 = ?` 结果肯定不是原来的5了。

再者,6台的服务器集群中,当某个主从群出现故障时,无法进行缓存,那我们需要把故障机器移除,所以取模数又会从6变成了5。我们计算的公式也会变化。

由于上面hash算法是使用取模来进行缓存的,为了规避上述情况,Hash一致性算法就诞生了~~

### 一致性Hash算法原理

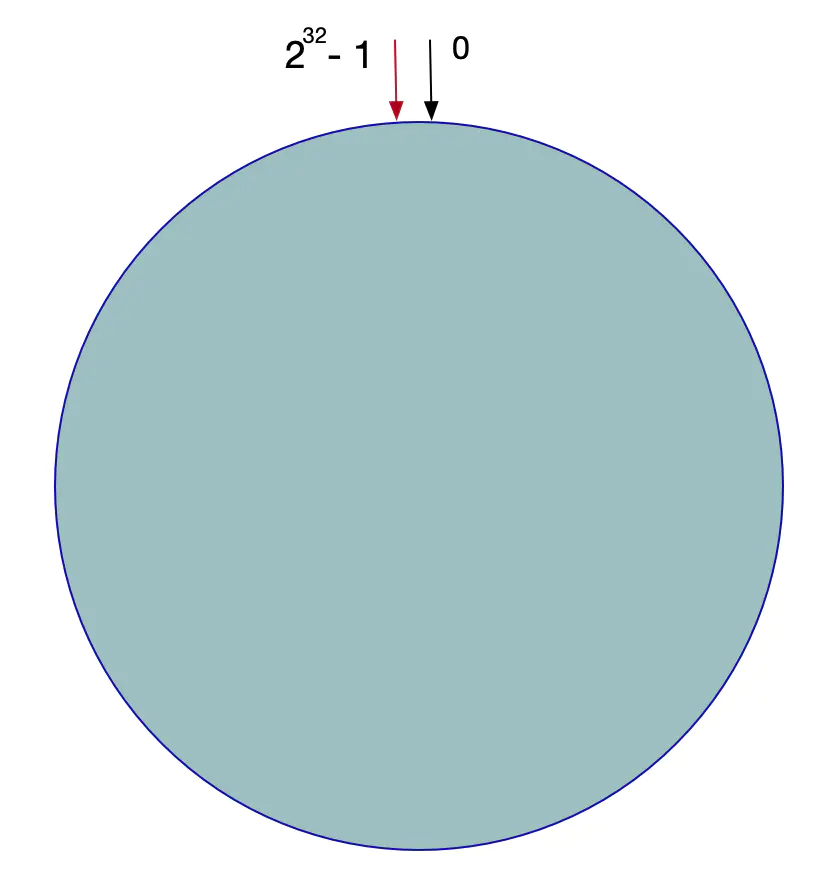

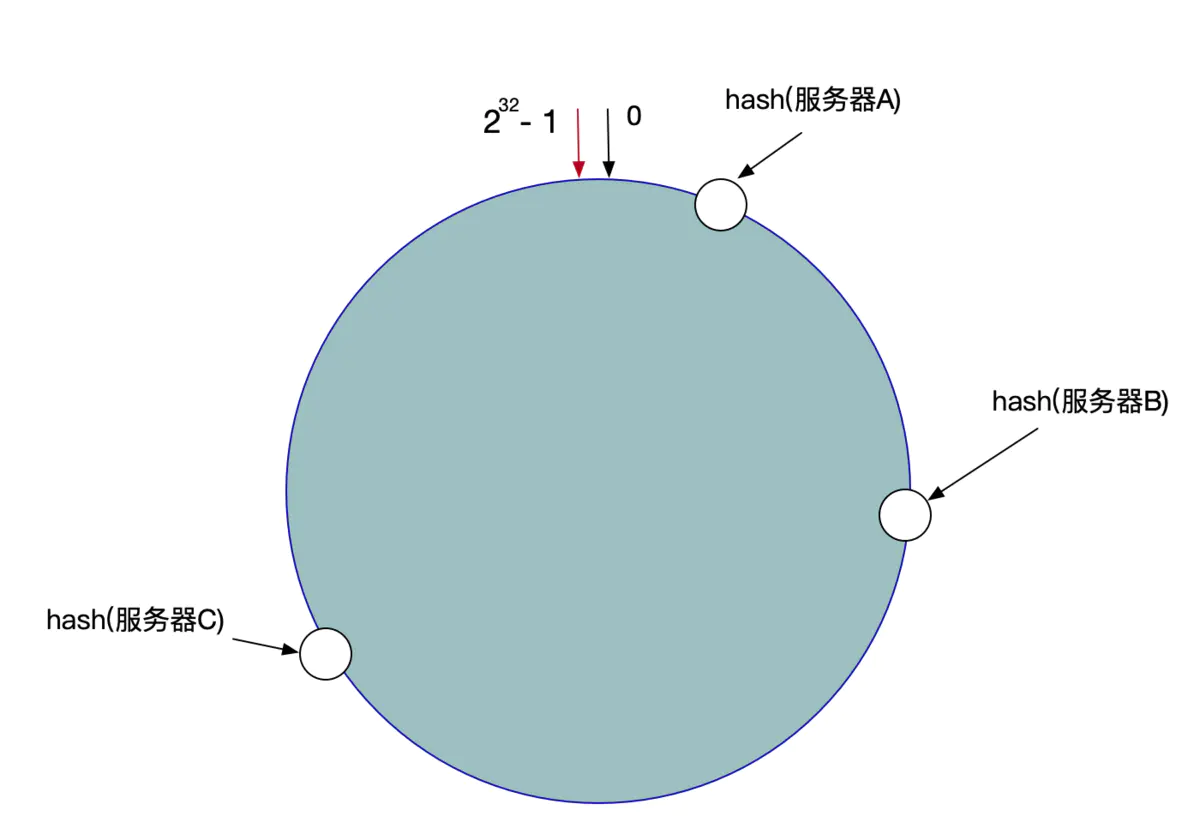

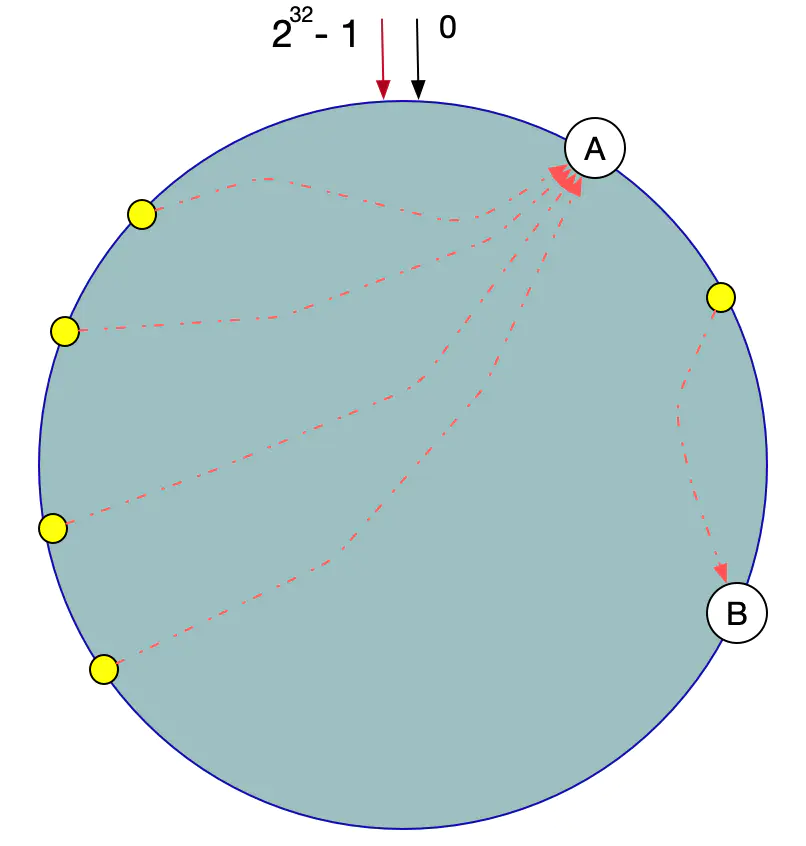

一致性Hash算法也是使用取模的方法,不过,上述的取模方法是对服务器的数量进行取模,而一致性的Hash算法是对`2的32方`取模。即,一致性Hash算法将整个Hash空间组织成一个虚拟的圆环,Hash函数的值空间为`0 ~ 2^32 - 1(一个32位无符号整型)`,整个哈希环如下:

图1-4:Hash圆环

整个圆环以`顺时针方向组织`,圆环正上方的点代表0,0点右侧的第一个点代表1,以此类推。

第二步,我们将各个服务器使用Hash进行一个哈希,具体可以选择服务器的IP或主机名作为关键字进行哈希,这样每台服务器就确定在了哈希环的一个位置上,比如我们有三台机器,使用IP地址哈希后在环空间的位置如图1-4所示:

图1-4:服务器在哈希环上的位置

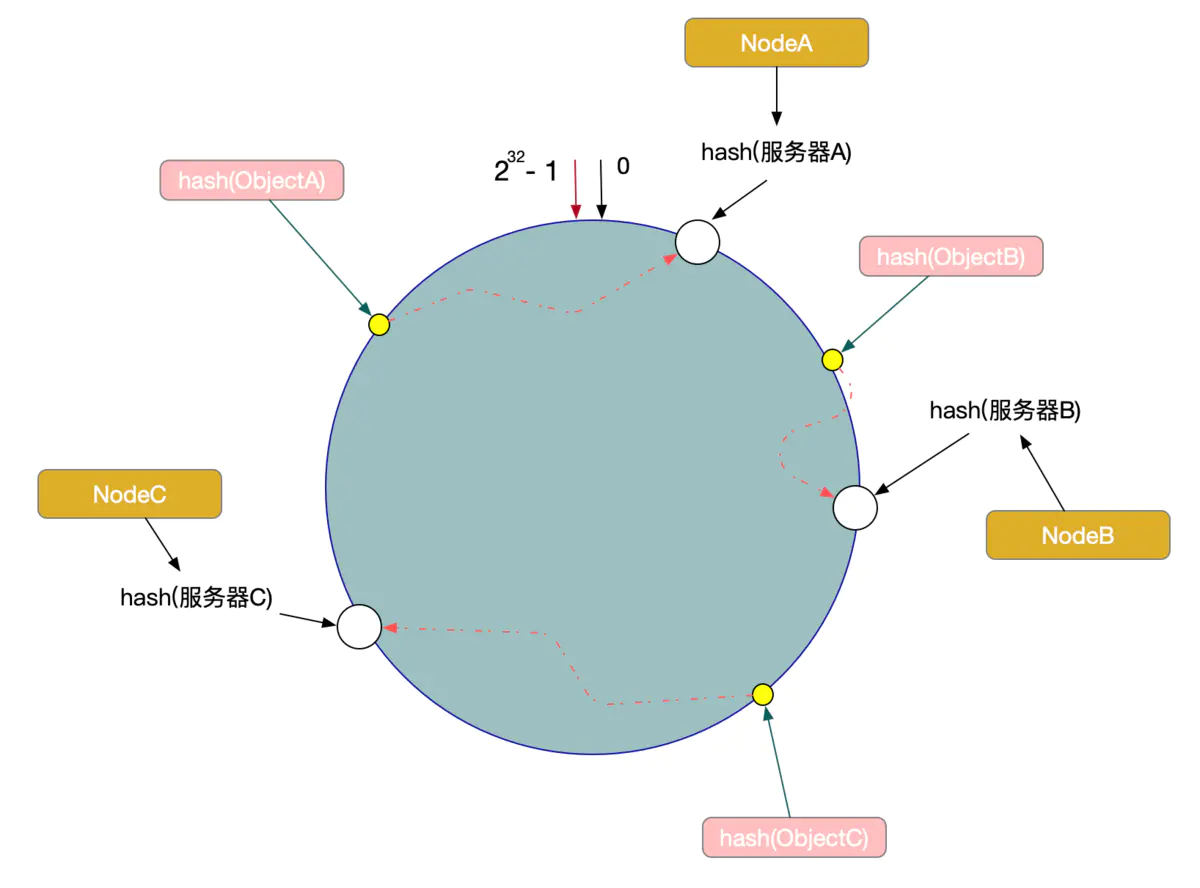

现在,我们使用以下算法定位数据访问到相应的服务器:

> 将数据Key使用相同的函数Hash计算出哈希值,并确定此数据在环上的位置,从此位置沿环顺时针查找,遇到的服务器就是其应该定位到的服务器。

例如,现在有ObjectA,ObjectB,ObjectC三个数据对象,经过哈希计算后,在环空间上的位置如下:

图1-5:数据对象在环上的位置

根据一致性算法,Object -> NodeA,ObjectB -> NodeB, ObjectC -> NodeC

### 一致性Hash算法的容错性和可扩展性

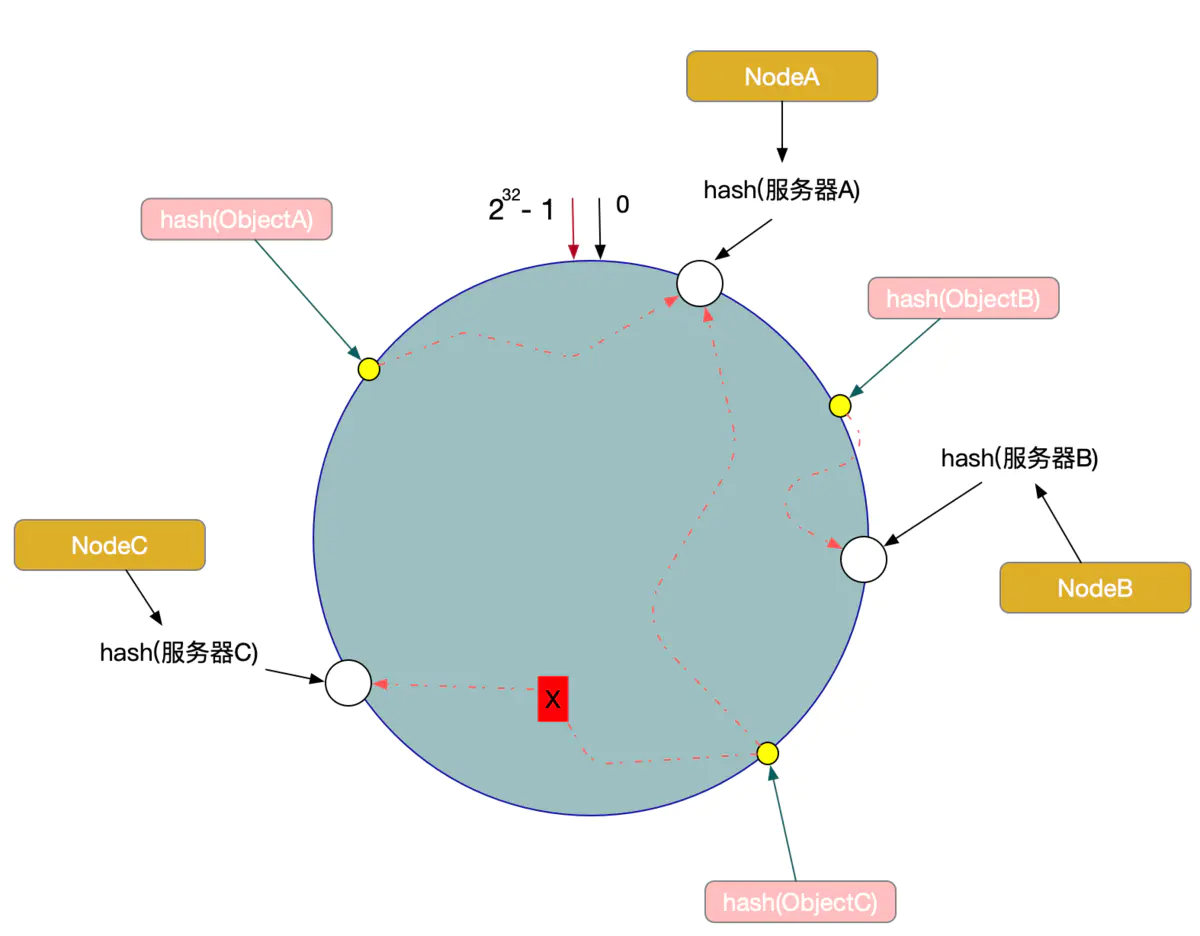

现在,假设我们的Node C宕机了,我们从图中可以看到,A、B不会受到影响,只有Object C对象被重新定位到Node A。所以我们发现,在一致性Hash算法中,如果一台服务器不可用,受影响的数据仅仅是此服务器到其环空间前一台服务器之间的数据(这里为Node C到Node B之间的数据),其他不会受到影响。如图1-6所示:

图1-6:C节点宕机情况,数据移到节点A上

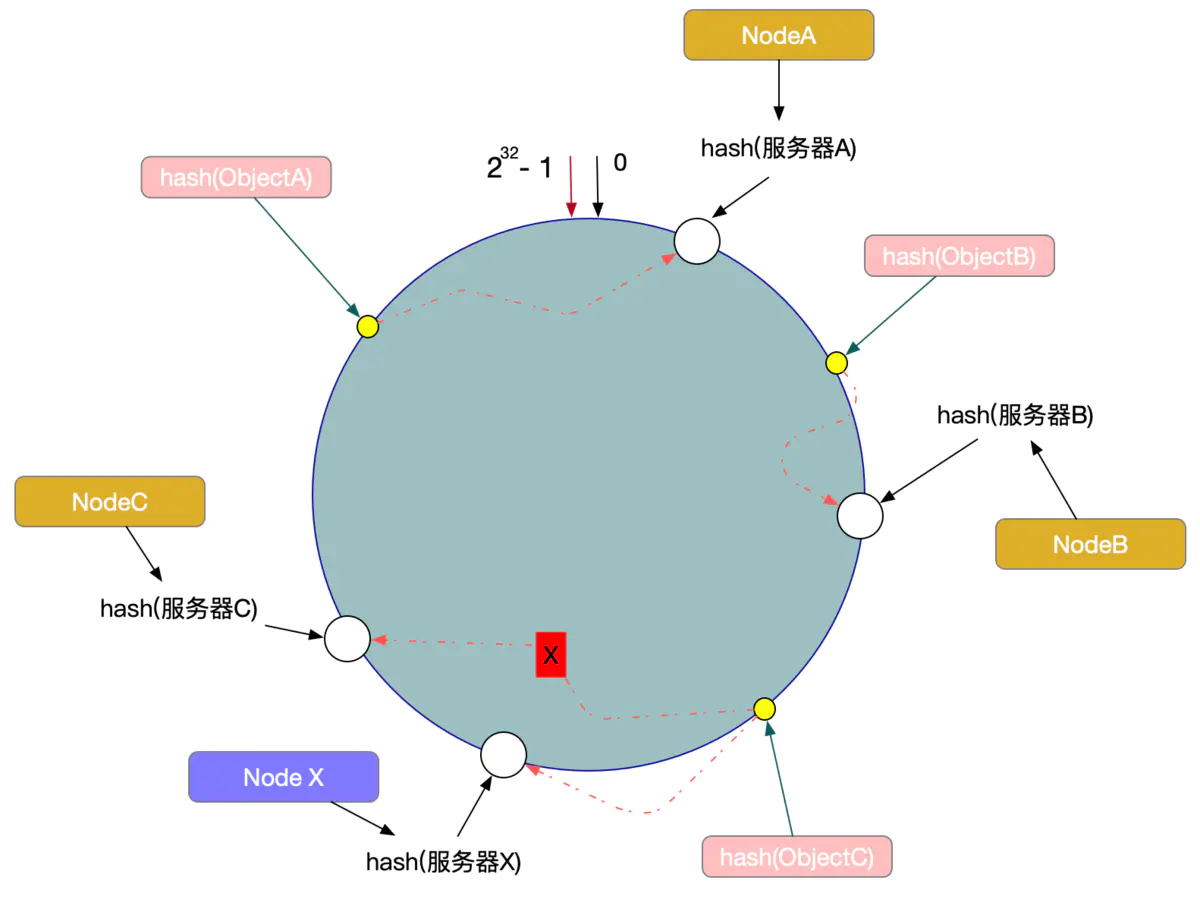

另外一种情况,现在我们系统增加了一台服务器Node X,如图1-7所示:

图1-7:增加新的服务器节点X

此时对象ObjectA、ObjectB没有受到影响,只有Object C重新定位到了新的节点X上。

如上所述:

> 一致性Hash算法对于节点的增减都只需重定位环空间中的一小部分数据,有很好的容错性和可扩展性。

### 数据倾斜问题

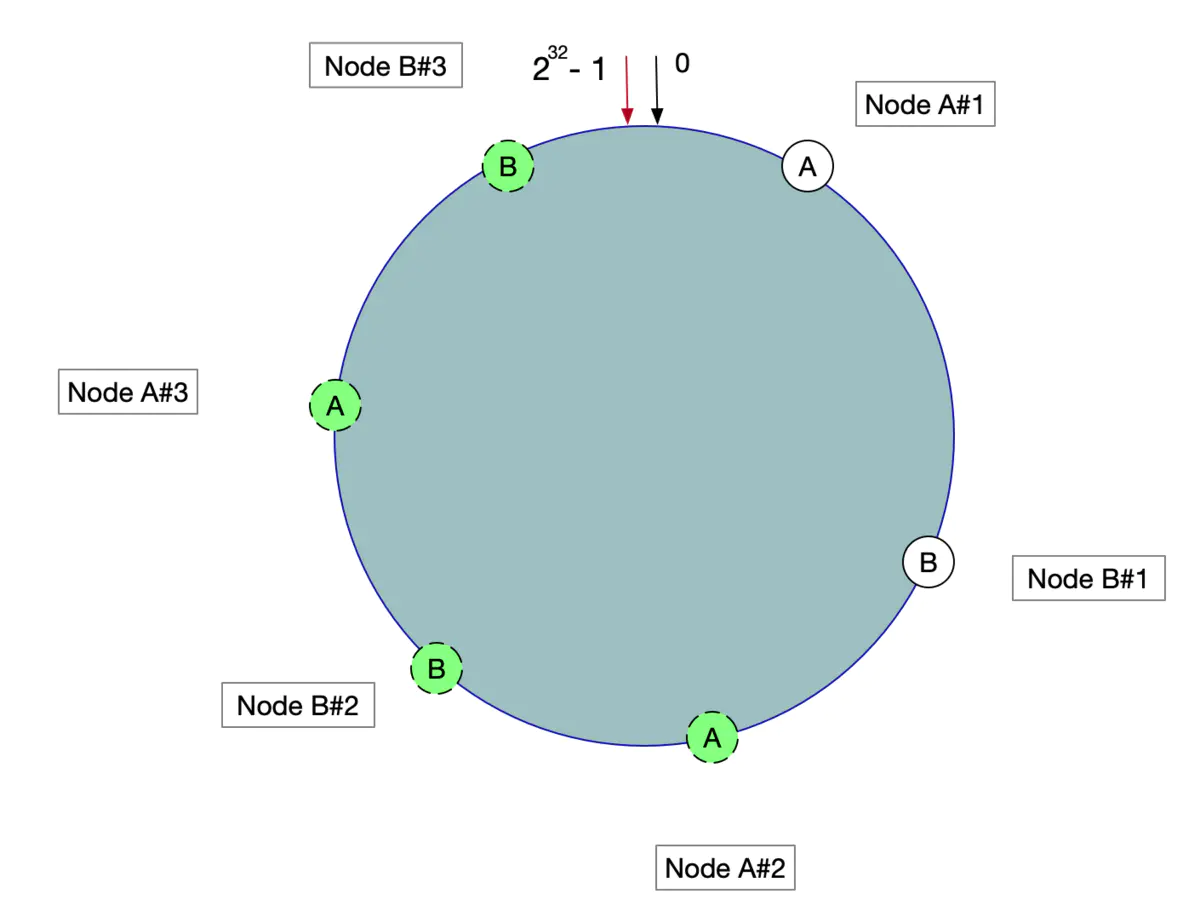

在一致性Hash算法服务节点太少的情况下,容易因为节点分布不均匀面造成`数据倾斜(被缓存的对象大部分缓存在某一台服务器上)问题`,如图1-8特例:

图1-8:数据倾斜

这时我们发现有大量数据集中在节点A上,而节点B只有少量数据。为了解决数据倾斜问题,一致性Hash算法引入了`虚拟节点机制`,即对每一个服务器节点计算多个哈希,每个计算结果位置都放置一个此服务节点,称为虚拟节点。

具体操作可以为服务器IP或主机名后加入编号来实现,实现如图1-9所示:

图1-9:增加虚拟节点情况

数据定位算法不变,只需要增加一步:虚拟节点到实际点的映射。

所以加入虚拟节点之后,即使在服务节点很少的情况下,也能做到数据的均匀分布。

### 具体实现

###### 算法接口类

~~~csharp

public interface IHashService {

Long hash(String key);

}

~~~

###### 算法接口实现类

~~~java

public class HashService implements IHashService {

/**

* MurMurHash算法,性能高,碰撞率低

*

* @param key String

* @return Long

*/

public Long hash(String key) {

ByteBuffer buf = ByteBuffer.wrap(key.getBytes());

int seed = 0x1234ABCD;

ByteOrder byteOrder = buf.order();

buf.order(ByteOrder.LITTLE_ENDIAN);

long m = 0xc6a4a7935bd1e995L;

int r = 47;

long h = seed ^ (buf.remaining() * m);

long k;

while (buf.remaining() >= 8) {

k = buf.getLong();

k *= m;

k ^= k >>> r;

k *= m;

h ^= k;

h *= m;

}

if (buf.remaining() > 0) {

ByteBuffer finish = ByteBuffer.allocate(8).order(ByteOrder.LITTLE_ENDIAN);

finish.put(buf).rewind();

h ^= finish.getLong();

h *= m;

}

h ^= h >>> r;

h *= m;

h ^= h >>> r;

buf.order(byteOrder);

return h;

}

}

~~~

###### 模拟机器节点

~~~tsx

public class Node<T> {

private String ip;

private String name;

public Node(String ip, String name) {

this.ip = ip;

this.name = name;

}

public String getIp() {

return ip;

}

public void setIp(String ip) {

this.ip = ip;

}

public String getName() {

return name;

}

public void setName(String name) {

this.name = name;

}

/**

* 使用IP当做hash的Key

*

* @return String

*/

@Override

public String toString() {

return ip;

}

}

~~~

###### 一致性Hash操作

~~~kotlin

public class ConsistentHash<T> {

// Hash函数接口

private final IHashService iHashService;

// 每个机器节点关联的虚拟节点数量

private final int numberOfReplicas;

// 环形虚拟节点

private final SortedMap<Long, T> circle = new TreeMap<Long, T>();

public ConsistentHash(IHashService iHashService, int numberOfReplicas, Collection<T> nodes) {

this.iHashService = iHashService;

this.numberOfReplicas = numberOfReplicas;

for (T node : nodes) {

add(node);

}

}

/**

* 增加真实机器节点

*

* @param node T

*/

public void add(T node) {

for (int i = 0; i < this.numberOfReplicas; i++) {

circle.put(this.iHashService.hash(node.toString() + i), node);

}

}

/**

* 删除真实机器节点

*

* @param node T

*/

public void remove(T node) {

for (int i = 0; i < this.numberOfReplicas; i++) {

circle.remove(this.iHashService.hash(node.toString() + i));

}

}

public T get(String key) {

if (circle.isEmpty()) return null;

long hash = iHashService.hash(key);

// 沿环的顺时针找到一个虚拟节点

if (!circle.containsKey(hash)) {

SortedMap<Long, T> tailMap = circle.tailMap(hash);

hash = tailMap.isEmpty() ? circle.firstKey() : tailMap.firstKey();

}

return circle.get(hash);

}

}

~~~

###### 测试类

~~~dart

public class TestHashCircle {

// 机器节点IP前缀

private static final String IP_PREFIX = "192.168.0.";

public static void main(String[] args) {

// 每台真实机器节点上保存的记录条数

Map<String, Integer> map = new HashMap<String, Integer>();

// 真实机器节点, 模拟10台

List<Node<String>> nodes = new ArrayList<Node<String>>();

for (int i = 1; i <= 10; i++) {

map.put(IP_PREFIX + i, 0); // 初始化记录

Node<String> node = new Node<String>(IP_PREFIX + i, "node" + i);

nodes.add(node);

}

IHashService iHashService = new HashService();

// 每台真实机器引入100个虚拟节点

ConsistentHash<Node<String>> consistentHash = new ConsistentHash<Node<String>>(iHashService, 500, nodes);

// 将5000条记录尽可能均匀的存储到10台机器节点上

for (int i = 0; i < 5000; i++) {

// 产生随机一个字符串当做一条记录,可以是其它更复杂的业务对象,比如随机字符串相当于对象的业务唯一标识

String data = UUID.randomUUID().toString() + i;

// 通过记录找到真实机器节点

Node<String> node = consistentHash.get(data);

// 再这里可以能过其它工具将记录存储真实机器节点上,比如MemoryCache等

// ...

// 每台真实机器节点上保存的记录条数加1

map.put(node.getIp(), map.get(node.getIp()) + 1);

}

// 打印每台真实机器节点保存的记录条数

for (int i = 1; i <= 10; i++) {

System.out.println(IP_PREFIX + i + "节点记录条数:" + map.get(IP_PREFIX + i));

}

}

}

~~~

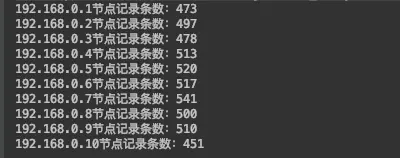

运行结果如下:

一致性hash测试结果

每台机器映射的虚拟节点越多,则分布的越均匀~~~

感兴趣的同学可以拷贝上面的代码运行尝试一下。

作者:oneape15

转载链接:https://www.jianshu.com/p/528ce5cd7e8f

- 一.JVM

- 1.1 java代码是怎么运行的

- 1.2 JVM的内存区域

- 1.3 JVM运行时内存

- 1.4 JVM内存分配策略

- 1.5 JVM类加载机制与对象的生命周期

- 1.6 常用的垃圾回收算法

- 1.7 JVM垃圾收集器

- 1.8 CMS垃圾收集器

- 1.9 G1垃圾收集器

- 2.面试相关文章

- 2.1 可能是把Java内存区域讲得最清楚的一篇文章

- 2.0 GC调优参数

- 2.1GC排查系列

- 2.2 内存泄漏和内存溢出

- 2.2.3 深入理解JVM-hotspot虚拟机对象探秘

- 1.10 并发的可达性分析相关问题

- 二.Java集合架构

- 1.ArrayList深入源码分析

- 2.Vector深入源码分析

- 3.LinkedList深入源码分析

- 4.HashMap深入源码分析

- 5.ConcurrentHashMap深入源码分析

- 6.HashSet,LinkedHashSet 和 LinkedHashMap

- 7.容器中的设计模式

- 8.集合架构之面试指南

- 9.TreeSet和TreeMap

- 三.Java基础

- 1.基础概念

- 1.1 Java程序初始化的顺序是怎么样的

- 1.2 Java和C++的区别

- 1.3 反射

- 1.4 注解

- 1.5 泛型

- 1.6 字节与字符的区别以及访问修饰符

- 1.7 深拷贝与浅拷贝

- 1.8 字符串常量池

- 2.面向对象

- 3.关键字

- 4.基本数据类型与运算

- 5.字符串与数组

- 6.异常处理

- 7.Object 通用方法

- 8.Java8

- 8.1 Java 8 Tutorial

- 8.2 Java 8 数据流(Stream)

- 8.3 Java 8 并发教程:线程和执行器

- 8.4 Java 8 并发教程:同步和锁

- 8.5 Java 8 并发教程:原子变量和 ConcurrentMap

- 8.6 Java 8 API 示例:字符串、数值、算术和文件

- 8.7 在 Java 8 中避免 Null 检查

- 8.8 使用 Intellij IDEA 解决 Java 8 的数据流问题

- 四.Java 并发编程

- 1.线程的实现/创建

- 2.线程生命周期/状态转换

- 3.线程池

- 4.线程中的协作、中断

- 5.Java锁

- 5.1 乐观锁、悲观锁和自旋锁

- 5.2 Synchronized

- 5.3 ReentrantLock

- 5.4 公平锁和非公平锁

- 5.3.1 说说ReentrantLock的实现原理,以及ReentrantLock的核心源码是如何实现的?

- 5.5 锁优化和升级

- 6.多线程的上下文切换

- 7.死锁的产生和解决

- 8.J.U.C(java.util.concurrent)

- 0.简化版(快速复习用)

- 9.锁优化

- 10.Java 内存模型(JMM)

- 11.ThreadLocal详解

- 12 CAS

- 13.AQS

- 0.ArrayBlockingQueue和LinkedBlockingQueue的实现原理

- 1.DelayQueue的实现原理

- 14.Thread.join()实现原理

- 15.PriorityQueue 的特性和原理

- 16.CyclicBarrier的实际使用场景

- 五.Java I/O NIO

- 1.I/O模型简述

- 2.Java NIO之缓冲区

- 3.JAVA NIO之文件通道

- 4.Java NIO之套接字通道

- 5.Java NIO之选择器

- 6.基于 Java NIO 实现简单的 HTTP 服务器

- 7.BIO-NIO-AIO

- 8.netty(一)

- 9.NIO面试题

- 六.Java设计模式

- 1.单例模式

- 2.策略模式

- 3.模板方法

- 4.适配器模式

- 5.简单工厂

- 6.门面模式

- 7.代理模式

- 七.数据结构和算法

- 1.什么是红黑树

- 2.二叉树

- 2.1 二叉树的前序、中序、后序遍历

- 3.排序算法汇总

- 4.java实现链表及链表的重用操作

- 4.1算法题-链表反转

- 5.图的概述

- 6.常见的几道字符串算法题

- 7.几道常见的链表算法题

- 8.leetcode常见算法题1

- 9.LRU缓存策略

- 10.二进制及位运算

- 10.1.二进制和十进制转换

- 10.2.位运算

- 11.常见链表算法题

- 12.算法好文推荐

- 13.跳表

- 八.Spring 全家桶

- 1.Spring IOC

- 2.Spring AOP

- 3.Spring 事务管理

- 4.SpringMVC 运行流程和手动实现

- 0.Spring 核心技术

- 5.spring如何解决循环依赖问题

- 6.springboot自动装配原理

- 7.Spring中的循环依赖解决机制中,为什么要三级缓存,用二级缓存不够吗

- 8.beanFactory和factoryBean有什么区别

- 九.数据库

- 1.mybatis

- 1.1 MyBatis-# 与 $ 区别以及 sql 预编译

- Mybatis系列1-Configuration

- Mybatis系列2-SQL执行过程

- Mybatis系列3-之SqlSession

- Mybatis系列4-之Executor

- Mybatis系列5-StatementHandler

- Mybatis系列6-MappedStatement

- Mybatis系列7-参数设置揭秘(ParameterHandler)

- Mybatis系列8-缓存机制

- 2.浅谈聚簇索引和非聚簇索引的区别

- 3.mysql 证明为什么用limit时,offset很大会影响性能

- 4.MySQL中的索引

- 5.数据库索引2

- 6.面试题收集

- 7.MySQL行锁、表锁、间隙锁详解

- 8.数据库MVCC详解

- 9.一条SQL查询语句是如何执行的

- 10.MySQL 的 crash-safe 原理解析

- 11.MySQL 性能优化神器 Explain 使用分析

- 12.mysql中,一条update语句执行的过程是怎么样的?期间用到了mysql的哪些log,分别有什么作用

- 十.Redis

- 0.快速复习回顾Redis

- 1.通俗易懂的Redis数据结构基础教程

- 2.分布式锁(一)

- 3.分布式锁(二)

- 4.延时队列

- 5.位图Bitmaps

- 6.Bitmaps(位图)的使用

- 7.Scan

- 8.redis缓存雪崩、缓存击穿、缓存穿透

- 9.Redis为什么是单线程、及高并发快的3大原因详解

- 10.布隆过滤器你值得拥有的开发利器

- 11.Redis哨兵、复制、集群的设计原理与区别

- 12.redis的IO多路复用

- 13.相关redis面试题

- 14.redis集群

- 十一.中间件

- 1.RabbitMQ

- 1.1 RabbitMQ实战,hello world

- 1.2 RabbitMQ 实战,工作队列

- 1.3 RabbitMQ 实战, 发布订阅

- 1.4 RabbitMQ 实战,路由

- 1.5 RabbitMQ 实战,主题

- 1.6 Spring AMQP 的 AMQP 抽象

- 1.7 Spring AMQP 实战 – 整合 RabbitMQ 发送邮件

- 1.8 RabbitMQ 的消息持久化与 Spring AMQP 的实现剖析

- 1.9 RabbitMQ必备核心知识

- 2.RocketMQ 的几个简单问题与答案

- 2.Kafka

- 2.1 kafka 基础概念和术语

- 2.2 Kafka的重平衡(Rebalance)

- 2.3.kafka日志机制

- 2.4 kafka是pull还是push的方式传递消息的?

- 2.5 Kafka的数据处理流程

- 2.6 Kafka的脑裂预防和处理机制

- 2.7 Kafka中partition副本的Leader选举机制

- 2.8 如果Leader挂了的时候,follower没来得及同步,是否会出现数据不一致

- 2.9 kafka的partition副本是否会出现脑裂情况

- 十二.Zookeeper

- 0.什么是Zookeeper(漫画)

- 1.使用docker安装Zookeeper伪集群

- 3.ZooKeeper-Plus

- 4.zk实现分布式锁

- 5.ZooKeeper之Watcher机制

- 6.Zookeeper之选举及数据一致性

- 十三.计算机网络

- 1.进制转换:二进制、八进制、十六进制、十进制之间的转换

- 2.位运算

- 3.计算机网络面试题汇总1

- 十四.Docker

- 100.面试题收集合集

- 1.美团面试常见问题总结

- 2.b站部分面试题

- 3.比心面试题

- 4.腾讯面试题

- 5.哈罗部分面试

- 6.笔记

- 十五.Storm

- 1.Storm和流处理简介

- 2.Storm 核心概念详解

- 3.Storm 单机版本环境搭建

- 4.Storm 集群环境搭建

- 5.Storm 编程模型详解

- 6.Storm 项目三种打包方式对比分析

- 7.Storm 集成 Redis 详解

- 8.Storm 集成 HDFS 和 HBase

- 9.Storm 集成 Kafka

- 十六.Elasticsearch

- 1.初识ElasticSearch

- 2.文档基本CRUD、集群健康检查

- 3.shard&replica

- 4.document核心元数据解析及ES的并发控制

- 5.document的批量操作及数据路由原理

- 6.倒排索引

- 十七.分布式相关

- 1.分布式事务解决方案一网打尽

- 2.关于xxx怎么保证高可用的问题

- 3.一致性hash原理与实现

- 4.微服务注册中心 Nacos 比 Eureka的优势

- 5.Raft 协议算法

- 6.为什么微服务架构中需要网关

- 0.CAP与BASE理论

- 十八.Dubbo

- 1.快速掌握Dubbo常规应用

- 2.Dubbo应用进阶

- 3.Dubbo调用模块详解

- 4.Dubbo调用模块源码分析

- 6.Dubbo协议模块