### 什么是Producer、Consumer、Broker、Topic、Partition?

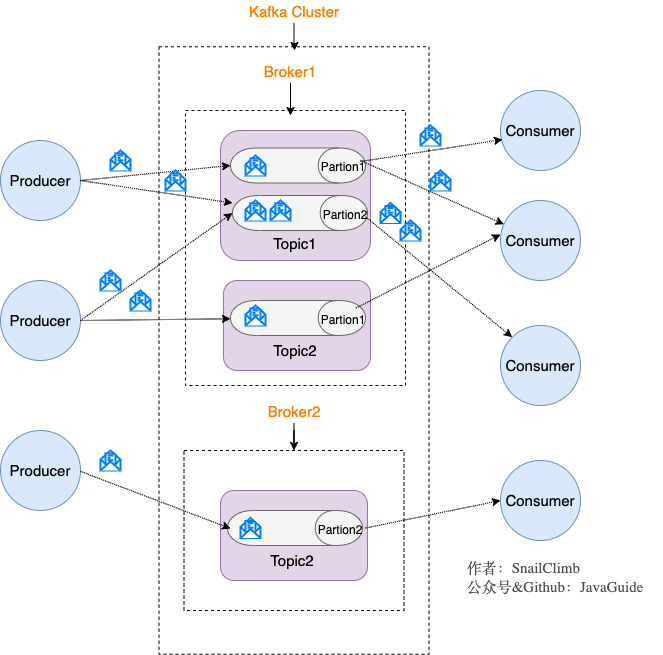

Kafka 将生产者发布的消息发送到 **Topic(主题)** 中,需要这些消息的消费者可以订阅这些 **Topic(主题)**,如下图所示:

上面这张图也为我们引出了,Kafka 比较重要的几个概念:

1. **Producer(生产者)** : 产生消息的一方。

2. **Consumer(消费者)** : 消费消息的一方。

3. **Broker(代理)** : 可以看作是一个独立的 Kafka 实例。多个 Kafka Broker 组成一个 Kafka Cluster。

同时,你一定也注意到每个 Broker 中又包含了 Topic 以及 Partition 这两个重要的概念:

- **Topic(主题)** : Producer 将消息发送到特定的主题,Consumer 通过订阅特定的 Topic(主题) 来消费消息。

- **Partition(分区)** : Partition 属于 Topic 的一部分。一个 Topic 可以有多个 Partition ,并且同一 Topic 下的 Partition 可以分布在不同的 Broker 上,这也就表明一个 Topic 可以横跨多个 Broker 。这正如我上面所画的图一样。

> 划重点:**Kafka 中的 Partition(分区) 实际上可以对应成为消息队列中的队列。这样是不是更好理解一点?**

我们把生产者和消费者统称为**客户端(Clients)**。你可以同时运行多个

生产者和消费者实例,这些实例会不断地向Kafka集群中的多个主题生产和消费消息

有客户端自然也就有服务器端。Kafka的服务器端由被称为**Broker**的服务进程构成,即一个Kafka集群由多个Broker组成,Broker负责接收和处理客户端发送过来的请求,以及对消息进行持久化。

实现高可用的另一 个手段就是备份机制(Replication)。备份的思想很简单,就是把相同的数据拷贝到多台

机器上,而这些相同的数据拷贝在Kafka中被称为副本(Replica)。好吧,其实在整个分布式系统里好像都

叫这个名字。副本的数量是可以配置的,这些副本保存着相同的数据,但却有不同的角色和作用。Kafka定

义了两类副本:领导者副本(Leader Replica)和追随者副本(Follower Replica)。前者对外提供服务,这

里的对外指的是与客户端程序进行交互;而后者只是被动地追随领导者副本而已,不能与外界进行交互。当

然了,你可能知道在很多其他系统中追随者副本是可以对外提供服务的,比如MySQL的从库是可以处理读

操作的,但是在Kafka中追随者副本不会对外提供服务。对了,一个有意思的事情是现在已经不提倡使用

Master-Slave来指代这种主从关系了,毕竟Slave有奴隶的意思,在美国这种严禁种族歧视的国度,这种表

述有点政治不正确了,所以目前大部分的系统都改成Leader-Follower了。

副本的工作机制也很简单:生产者总是向领导者副本写消息;而消费者总是从领导者副本读消息。至于追随

者副本,它只做一件事:向领导者副本发送请求,请求领导者把最新生产的消息发给它,这样它能保持与领

导者的同步。

讲到这里,你可能有这样的疑问:刚才提到的副本如何与这里的分区联系在一起呢?实际上,副本是在分区

这个层级定义的。每个分区下可以配置若干个副本,其中只能有1个领导者副本和N-1个追随者副本。生产

者向分区写入消息,每条消息在分区中的位置信息由一个叫位移(Offset)的数据来表征。分区位移总是从

0开始,假设一个生产者向一个空分区写入了10条消息,那么这10条消息的位移依次是0、

1、2、、9。

*****

至此我们能够完整地串联起Kafka的三层消息架构:

●**第一层是主题层**,每个主题可以配置M个分区,而每个分区又可以配置N个副本

●**第二层是分区层**,每个分区的N个副本中只能有一个充当领导者角色,对外提供服务;其他N-1个副本是

追随者副本,只是提供数据冗余之用。

●**第三层是消息层**,分区中包含若干条消息,每条消息的位移从0开始,依次递增。

●**最后**,客户端程序只能与分区的领导者副本进行交互。

*****

#### KafkaBroker的持久化

讲完了消息层次,我们来说说KafkaBroker是如何持久化数据的。

总的来说,Kafka使用**消息日志(Log)**来保存数据,一个日志就是磁盘上一个只能**追加写(Append-only)消息**的物理文件。**因为只能追加写入,故避免了缓慢的随机I/O操作,改为性能较好的顺序I/0写操作,这也是实现Kafka高春吐量特性的一个重要手段**。不过如果你不停地向一个日志写入消息,最终也会耗尽所有的磁盘空间,因此Kafka必然要定期地删除消息以回收磁盘。怎么删除呢?简单来说就是通过**日志段LogSegment)机制**。在Kafka底层,一个日志又近一步细分成多个日志段,消息被追加写到当前最新的日志段中,当写满了一个日志段后,Kafka会自动切分出一个新的日志段,并将老的日志段封存起来。Kafka在后台还有定时任务会定期地检查老的日志段是否能够被删除,从而实现回收磁盘空间的目的。

*****

#### 消息模型

我们知道有两种消息模型,即点对点模型(Peer to Peer,P2P)和发布订阅模型。这里面的点对点指的是同一条消息只能被下游的一个消费者消费,其他消费者则不能染指。在Kafka中实现这种P2P模型的方法就是引入了**消费者组(Consumer Group)。所谓的消费者组,指的是多个消费者实例共同组成一个组来消费一组主题。这组主题中的每个分区都只会被组内的一个消费者实例消费,其他消费者实例不能消费它。为什么要引入消费者组呢?主要是为了提升消费者端的吞吐量**。多个消费者实例同时消费,加速整个消费端的吞吐量(TPS)。我会在专栏的后面详细介绍消费者组机制,所以现在你只需要了解消费者组是做什么的即可。另外这里的消费者实例可以是运行消费者应用的进程,也可以是一个线程,它们都称为一个消费者实例(Consumer Instance)。

消费者组里面的所有消费者实例不仅“瓜分”订阅主题的数据,而且更酷的是它们还能彼此协助。假设组内

某个实例挂掉了,Kafka能够自动检测到,然后把这个Failed实例之前负责的分区转移给其他活着的消费

者。这个过程就是Kafka中大名鼎鼎的“**重平衡”(Rebalance)**。

- 一.JVM

- 1.1 java代码是怎么运行的

- 1.2 JVM的内存区域

- 1.3 JVM运行时内存

- 1.4 JVM内存分配策略

- 1.5 JVM类加载机制与对象的生命周期

- 1.6 常用的垃圾回收算法

- 1.7 JVM垃圾收集器

- 1.8 CMS垃圾收集器

- 1.9 G1垃圾收集器

- 2.面试相关文章

- 2.1 可能是把Java内存区域讲得最清楚的一篇文章

- 2.0 GC调优参数

- 2.1GC排查系列

- 2.2 内存泄漏和内存溢出

- 2.2.3 深入理解JVM-hotspot虚拟机对象探秘

- 1.10 并发的可达性分析相关问题

- 二.Java集合架构

- 1.ArrayList深入源码分析

- 2.Vector深入源码分析

- 3.LinkedList深入源码分析

- 4.HashMap深入源码分析

- 5.ConcurrentHashMap深入源码分析

- 6.HashSet,LinkedHashSet 和 LinkedHashMap

- 7.容器中的设计模式

- 8.集合架构之面试指南

- 9.TreeSet和TreeMap

- 三.Java基础

- 1.基础概念

- 1.1 Java程序初始化的顺序是怎么样的

- 1.2 Java和C++的区别

- 1.3 反射

- 1.4 注解

- 1.5 泛型

- 1.6 字节与字符的区别以及访问修饰符

- 1.7 深拷贝与浅拷贝

- 1.8 字符串常量池

- 2.面向对象

- 3.关键字

- 4.基本数据类型与运算

- 5.字符串与数组

- 6.异常处理

- 7.Object 通用方法

- 8.Java8

- 8.1 Java 8 Tutorial

- 8.2 Java 8 数据流(Stream)

- 8.3 Java 8 并发教程:线程和执行器

- 8.4 Java 8 并发教程:同步和锁

- 8.5 Java 8 并发教程:原子变量和 ConcurrentMap

- 8.6 Java 8 API 示例:字符串、数值、算术和文件

- 8.7 在 Java 8 中避免 Null 检查

- 8.8 使用 Intellij IDEA 解决 Java 8 的数据流问题

- 四.Java 并发编程

- 1.线程的实现/创建

- 2.线程生命周期/状态转换

- 3.线程池

- 4.线程中的协作、中断

- 5.Java锁

- 5.1 乐观锁、悲观锁和自旋锁

- 5.2 Synchronized

- 5.3 ReentrantLock

- 5.4 公平锁和非公平锁

- 5.3.1 说说ReentrantLock的实现原理,以及ReentrantLock的核心源码是如何实现的?

- 5.5 锁优化和升级

- 6.多线程的上下文切换

- 7.死锁的产生和解决

- 8.J.U.C(java.util.concurrent)

- 0.简化版(快速复习用)

- 9.锁优化

- 10.Java 内存模型(JMM)

- 11.ThreadLocal详解

- 12 CAS

- 13.AQS

- 0.ArrayBlockingQueue和LinkedBlockingQueue的实现原理

- 1.DelayQueue的实现原理

- 14.Thread.join()实现原理

- 15.PriorityQueue 的特性和原理

- 16.CyclicBarrier的实际使用场景

- 五.Java I/O NIO

- 1.I/O模型简述

- 2.Java NIO之缓冲区

- 3.JAVA NIO之文件通道

- 4.Java NIO之套接字通道

- 5.Java NIO之选择器

- 6.基于 Java NIO 实现简单的 HTTP 服务器

- 7.BIO-NIO-AIO

- 8.netty(一)

- 9.NIO面试题

- 六.Java设计模式

- 1.单例模式

- 2.策略模式

- 3.模板方法

- 4.适配器模式

- 5.简单工厂

- 6.门面模式

- 7.代理模式

- 七.数据结构和算法

- 1.什么是红黑树

- 2.二叉树

- 2.1 二叉树的前序、中序、后序遍历

- 3.排序算法汇总

- 4.java实现链表及链表的重用操作

- 4.1算法题-链表反转

- 5.图的概述

- 6.常见的几道字符串算法题

- 7.几道常见的链表算法题

- 8.leetcode常见算法题1

- 9.LRU缓存策略

- 10.二进制及位运算

- 10.1.二进制和十进制转换

- 10.2.位运算

- 11.常见链表算法题

- 12.算法好文推荐

- 13.跳表

- 八.Spring 全家桶

- 1.Spring IOC

- 2.Spring AOP

- 3.Spring 事务管理

- 4.SpringMVC 运行流程和手动实现

- 0.Spring 核心技术

- 5.spring如何解决循环依赖问题

- 6.springboot自动装配原理

- 7.Spring中的循环依赖解决机制中,为什么要三级缓存,用二级缓存不够吗

- 8.beanFactory和factoryBean有什么区别

- 九.数据库

- 1.mybatis

- 1.1 MyBatis-# 与 $ 区别以及 sql 预编译

- Mybatis系列1-Configuration

- Mybatis系列2-SQL执行过程

- Mybatis系列3-之SqlSession

- Mybatis系列4-之Executor

- Mybatis系列5-StatementHandler

- Mybatis系列6-MappedStatement

- Mybatis系列7-参数设置揭秘(ParameterHandler)

- Mybatis系列8-缓存机制

- 2.浅谈聚簇索引和非聚簇索引的区别

- 3.mysql 证明为什么用limit时,offset很大会影响性能

- 4.MySQL中的索引

- 5.数据库索引2

- 6.面试题收集

- 7.MySQL行锁、表锁、间隙锁详解

- 8.数据库MVCC详解

- 9.一条SQL查询语句是如何执行的

- 10.MySQL 的 crash-safe 原理解析

- 11.MySQL 性能优化神器 Explain 使用分析

- 12.mysql中,一条update语句执行的过程是怎么样的?期间用到了mysql的哪些log,分别有什么作用

- 十.Redis

- 0.快速复习回顾Redis

- 1.通俗易懂的Redis数据结构基础教程

- 2.分布式锁(一)

- 3.分布式锁(二)

- 4.延时队列

- 5.位图Bitmaps

- 6.Bitmaps(位图)的使用

- 7.Scan

- 8.redis缓存雪崩、缓存击穿、缓存穿透

- 9.Redis为什么是单线程、及高并发快的3大原因详解

- 10.布隆过滤器你值得拥有的开发利器

- 11.Redis哨兵、复制、集群的设计原理与区别

- 12.redis的IO多路复用

- 13.相关redis面试题

- 14.redis集群

- 十一.中间件

- 1.RabbitMQ

- 1.1 RabbitMQ实战,hello world

- 1.2 RabbitMQ 实战,工作队列

- 1.3 RabbitMQ 实战, 发布订阅

- 1.4 RabbitMQ 实战,路由

- 1.5 RabbitMQ 实战,主题

- 1.6 Spring AMQP 的 AMQP 抽象

- 1.7 Spring AMQP 实战 – 整合 RabbitMQ 发送邮件

- 1.8 RabbitMQ 的消息持久化与 Spring AMQP 的实现剖析

- 1.9 RabbitMQ必备核心知识

- 2.RocketMQ 的几个简单问题与答案

- 2.Kafka

- 2.1 kafka 基础概念和术语

- 2.2 Kafka的重平衡(Rebalance)

- 2.3.kafka日志机制

- 2.4 kafka是pull还是push的方式传递消息的?

- 2.5 Kafka的数据处理流程

- 2.6 Kafka的脑裂预防和处理机制

- 2.7 Kafka中partition副本的Leader选举机制

- 2.8 如果Leader挂了的时候,follower没来得及同步,是否会出现数据不一致

- 2.9 kafka的partition副本是否会出现脑裂情况

- 十二.Zookeeper

- 0.什么是Zookeeper(漫画)

- 1.使用docker安装Zookeeper伪集群

- 3.ZooKeeper-Plus

- 4.zk实现分布式锁

- 5.ZooKeeper之Watcher机制

- 6.Zookeeper之选举及数据一致性

- 十三.计算机网络

- 1.进制转换:二进制、八进制、十六进制、十进制之间的转换

- 2.位运算

- 3.计算机网络面试题汇总1

- 十四.Docker

- 100.面试题收集合集

- 1.美团面试常见问题总结

- 2.b站部分面试题

- 3.比心面试题

- 4.腾讯面试题

- 5.哈罗部分面试

- 6.笔记

- 十五.Storm

- 1.Storm和流处理简介

- 2.Storm 核心概念详解

- 3.Storm 单机版本环境搭建

- 4.Storm 集群环境搭建

- 5.Storm 编程模型详解

- 6.Storm 项目三种打包方式对比分析

- 7.Storm 集成 Redis 详解

- 8.Storm 集成 HDFS 和 HBase

- 9.Storm 集成 Kafka

- 十六.Elasticsearch

- 1.初识ElasticSearch

- 2.文档基本CRUD、集群健康检查

- 3.shard&replica

- 4.document核心元数据解析及ES的并发控制

- 5.document的批量操作及数据路由原理

- 6.倒排索引

- 十七.分布式相关

- 1.分布式事务解决方案一网打尽

- 2.关于xxx怎么保证高可用的问题

- 3.一致性hash原理与实现

- 4.微服务注册中心 Nacos 比 Eureka的优势

- 5.Raft 协议算法

- 6.为什么微服务架构中需要网关

- 0.CAP与BASE理论

- 十八.Dubbo

- 1.快速掌握Dubbo常规应用

- 2.Dubbo应用进阶

- 3.Dubbo调用模块详解

- 4.Dubbo调用模块源码分析

- 6.Dubbo协议模块